深度学习层的FLOPs(浮点运算次数)计算公式

这些公式用于计算各种类型层的FLOPs,以帮助评估模型的计算复杂度和性能需求。注意,FLOPs通常用于估算模型的计算需求,实际硬件上的性能可能受到许多因素的影响,如并行性、内存带宽等。FLOPs计算公式通常取决于RNN层的具体类型(如LSTM、GRU等),因为它们的运算涉及更多的复杂性。对于其他特殊类型的层,FLOPs的计算方式可能不同,具体取决于层的操作和参数。池化层通常没有FLOPs,因为它执

以下是各种常见深度学习层的FLOPs(浮点运算次数)计算公式:

-

卷积层(Convolutional Layer):

FLOPs计算公式:

FLOPs=2⋅KH⋅KW⋅Cin⋅Cout⋅OH⋅OW\text{FLOPs} = 2 \cdot K_H \cdot K_W \cdot C_{in} \cdot C_{out} \cdot O_H \cdot O_WFLOPs=2⋅KH⋅KW⋅Cin⋅Cout⋅OH⋅OW其中,KHK_HKH 和 KWK_WKW 是卷积核的高度和宽度,CinC_{in}Cin 是输入通道数,CoutC_{out}Cout 是输出通道数,OHO_HOH 和 OWO_WOW 分别是输出特征图的高度和宽度。

-

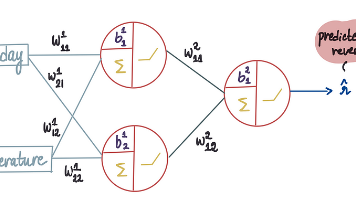

全连接层(Dense Layer):

FLOPs计算公式:

FLOPs=2⋅Nin⋅Nout\text{FLOPs} = 2 \cdot N_{in} \cdot N_{out}FLOPs=2⋅Nin⋅Nout其中,NinN_{in}Nin 表示上一层的神经元数,NoutN_{out}Nout 表示当前层的神经元数。

-

池化层(Pooling Layer):

池化层通常没有FLOPs,因为它执行的是最大值或平均值的固定操作,不涉及可学习参数。

-

循环神经网络层(Recurrent Layer):

FLOPs计算公式通常取决于RNN层的具体类型(如LSTM、GRU等),因为它们的运算涉及更多的复杂性。通常,RNN的FLOPs计算较为复杂,需要考虑时间步数和输入序列长度等因素。

-

其他层:

对于其他特殊类型的层,FLOPs的计算方式可能不同,具体取决于层的操作和参数。您需要查看深度学习框架的文档或模型的结构来了解如何计算特定层的FLOPs。

这些公式用于计算各种类型层的FLOPs,以帮助评估模型的计算复杂度和性能需求。注意,FLOPs通常用于估算模型的计算需求,实际硬件上的性能可能受到许多因素的影响,如并行性、内存带宽等。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)