普林斯顿:奖励模型在LLM强化学习中的作用

在通过人类反馈的强化学习(RLHF)中,如何评估和优化奖励模型,特别是探讨奖励模型的准确性与奖励方差之间的关系,以及这些因素如何影响优化效率。论文从优化的角度分析奖励模型的特性,提出准确的奖励模型不一定是更好的教师,并且不同的语言模型可能对不同的奖励模型有不同的响应。

📖标题:What Makes a Reward Model a Good Teacher? An Optimization Perspective

🌐来源:arXiv, 2503.15477

🌟摘要

🔸从人类反馈中强化学习(RLHF)的成功在很大程度上取决于奖励模型的质量。虽然这种质量主要通过准确性来评估,但尚不清楚准确性是否完全反映了奖励模式成为有效教师的原因。

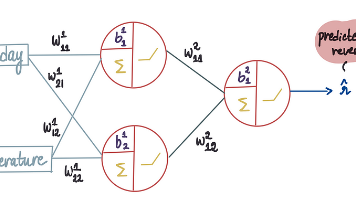

🔸我们从优化的角度来解决这个问题。首先,我们证明,无论奖励模型有多准确,如果它诱导了低奖励方差,那么RLHF目标就会受到平坦景观的影响。因此,即使是一个完全准确的奖励模型也可能导致极其缓慢的优化,表现不如导致更高奖励方差的不太准确的模型。我们还表明,对一种语言模型有效的奖励模型可以为另一种语言模式带来较低的奖励方差,从而形成平坦的客观景观。这些结果确立了仅基于准确性或独立于它们所指导的语言模型来评估奖励模型的根本局限性。

🔸使用多达8B个参数的模型的实验证实了我们的理论,证明了奖励方差、准确性和奖励最大化率之间的相互作用。总的来说,我们的研究结果强调,除了准确性之外,奖励模型还需要引入足够的方差才能进行有效的优化。

🛎️文章简介

🔸研究问题:在通过人类反馈的强化学习(RLHF)中,如何评估和优化奖励模型,特别是探讨奖励模型的准确性与奖励方差之间的关系,以及这些因素如何影响优化效率。

🔸主要贡献:论文从优化的角度分析奖励模型的特性,提出准确的奖励模型不一定是更好的教师,并且不同的语言模型可能对不同的奖励模型有不同的响应。

📝重点思路

🔸通过理论分析,证明奖励模型的准确性与奖励方差是影响优化效率的两个独立因素。

🔸采用数学定理来说明奖励方差低的奖励模型会导致优化效率低下,即使它们的准确性很高。

🔸在实验中,通过不同的奖励模型和策略初始化组合,验证理论分析的有效性,探讨奖励模型在具体RLHF场景下的应用效果。

🔎分析总结

🔸实验结果表明,奖励方差与奖励最大化速率之间存在显著相关性,较低的奖励方差可能导致更慢的奖励增加速率。

🔸在某些情况下,使用代理奖励模型(即不直接使用真实奖励)能够比直接使用真实奖励模型获得更好的效果,尤其是在训练的早期阶段。

🔸不同的语言模型在使用不同的奖励模型时表现出不同的奖励增加速率,强调了奖励模型选择的上下文依赖性。

💡个人观点

论文的核心在于明确区分了奖励模型的准确性和奖励方差对优化效果的影响,适当的奖励偏差能带来更好的探索。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)