强化学习实战案例:从理论到应用

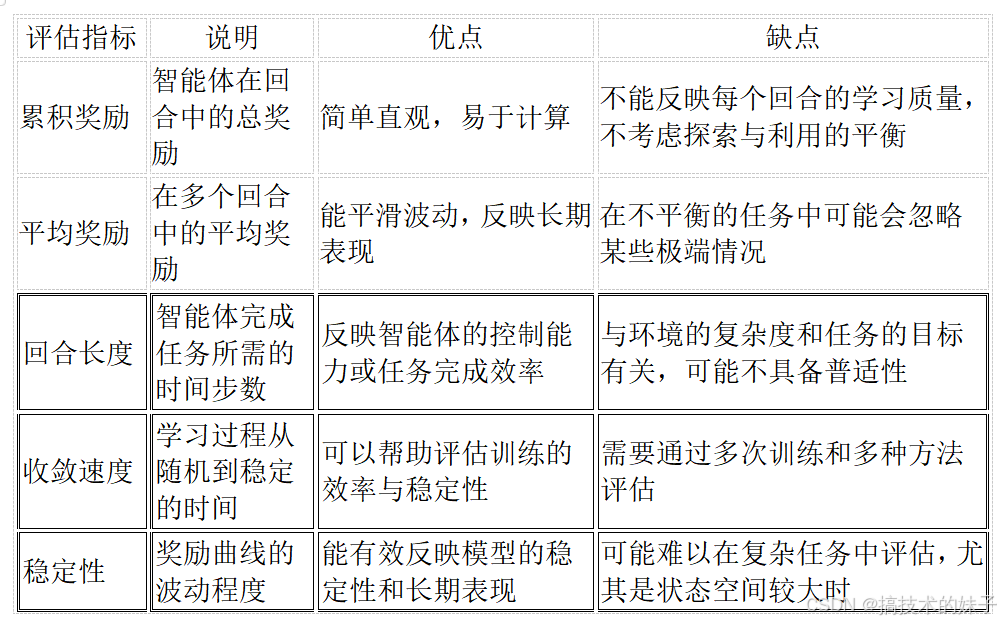

DQN 模型包含一个深度神经网络,用于逼近 Q 值函数。python])评估指标说明优点缺点累积奖励智能体在回合中的总奖励简单直观,易于计算不能反映每个回合的学习质量,不考虑探索与利用的平衡平均奖励在多个回合中的平均奖励能平滑波动,反映长期表现在不平衡的任务中可能会忽略某些极端情况回合长度智能体完成任务所需的时间步数反映智能体的控制能力或任务完成效率与环境的复杂度和任务的目标有关,可能不具备普适性

强化学习(Reinforcement Learning, RL)是机器学习的一种重要分支,它不同于传统的监督学习和无监督学习,而是通过让智能体(Agent)与环境(Environment)交互来学习一个策略,以最大化长期的回报。近年来,强化学习的应用越来越广泛,特别是在机器人控制、自动驾驶、游戏智能体和推荐系统等领域中。本文将深入介绍强化学习的理论背景、建模注意事项、调参方法、训练技巧,并给出一个完整的强化学习案例,帮助读者理解如何在实践中应用强化学习。

一、强化学习理论基础

1.1 强化学习的基本概念

强化学习涉及三个主要组成部分:

环境(Environment):系统的外部世界,智能体与环境交互并受到环境的反馈。

智能体(Agent):能够感知环境并做出决策的实体,目标是通过与环境的交互来最大化长期回报。

状态(State):环境在某一时刻的表现,智能体基于当前的状态作出决策。

动作(Action):智能体在某一状态下可以选择的行为。

奖励(Reward):环境对智能体的行为给予的反馈,智能体通过奖励信号来优化其策略。

策略(Policy):智能体选择动作的方式,通常是一个从状态到动作的映射。

价值函数(Value Function):用于评估某一状态或某一状态-动作对的价值,帮助智能体选择最佳策略。

回报(Return):智能体在一个时间步后累计的总奖励,通常用于衡量智能体的表现。

强化学习的目标是通过智能体不断与环境交互,找到一个最优策略,最大化长期的累计奖励。

1.2 马尔科夫决策过程(MDP)

强化学习通常假设环境能够通过马尔科夫决策过程(Markov Decision Process, MDP)来描述。MDP是一个五元组:(S,A,P,R,γ),其中:

S是状态空间(所有可能的状态的集合)。

A 是动作空间(所有可能的动作的集合)。

P 是状态转移概率,表示智能体执行某一动作后从一个状态转移到另一个状态的概率。

R 是奖励函数,表示智能体在某一状态-动作对下获得的即时奖励。

γ是折扣因子,用于权衡未来奖励与当前奖励的重要性。

通过这种方式,强化学习的目标是最大化智能体从当前状态开始,经过多个时间步的行动所获得的累计折扣奖励:

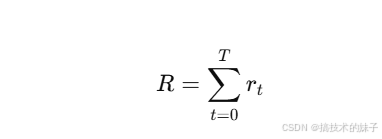

其中,Rt是从时间步 t开始的累计奖励,γ 是折扣因子,T是任务的最大时间步。

1.3 强化学习的核心任务

强化学习的核心任务是解决以下问题:

策略优化:通过与环境的交互,智能体学习到一个策略,使得在任意状态下采取的动作最大化期望回报。

价值评估:通过评估每个状态的价值或每个状态-动作对的价值,指导智能体的行为选择。

探索与利用的平衡:智能体在执行任务时需要平衡“探索”(尝试新的动作)和“利用”(选择已知的最佳动作)之间的权衡。

1.4 强化学习的算法分类

强化学习的算法主要可以分为以下几类:

值迭代方法(Value Iteration Methods):通过计算每个状态的价值,帮助智能体选择最优的动作。包括 Q-learning 和 SARSA。

策略梯度方法(Policy Gradient Methods):通过直接优化策略的参数来更新策略。包括 REINFORCE 和 Actor-Critic。

模型基方法(Model-Based Methods):构建环境模型,通过模拟环境来做决策,减少实际交互的需求。

深度强化学习(Deep Reinforcement Learning):结合深度学习和强化学习,使用神经网络来逼近复杂的价值函数或策略。

二、强化学习建模注意事项

在进行强化学习建模时,有几个关键注意事项需要特别关注:

2.1 状态和动作空间的设计

状态空间和动作空间的设计直接决定了问题的复杂度和模型的效果。对于大规模的任务,状态和动作的空间往往是巨大的,需要通过适当的设计来简化问题。以下是一些设计技巧:

**离散化:**对于连续的状态空间或动作空间,可以考虑通过离散化方法将其转化为离散的空间,方便处理。

**特征提取:**有时候原始状态空间过于庞大,需要通过特征提取来提取重要的特征,减少维度。

**动作限制:**为了减少动作空间的复杂度,可以设置一些动作的限制或约束条件。

2.2 奖励设计

奖励设计是强化学习建模中的一个挑战,奖励信号需要能够准确反映任务目标。以下是一些设计技巧:

**稀疏奖励:**对于许多任务,奖励信号可能非常稀疏,智能体可能很难获得即时反馈。可以通过设计合适的奖励函数,或使用技术如奖励塑造(Reward Shaping)来解决这个问题。

**延迟奖励:**在一些任务中,智能体的行为可能对最终结果产生延迟影响。需要设计长期奖励的计算方法,例如使用折扣因子(γ\gammaγ)来调整未来奖励的权重。

**负奖励:**通过对不良行为给予负奖励,来引导智能体避免错误行为。

2.3 探索与利用的平衡

在训练过程中,智能体需要平衡“探索”和“利用”之间的关系。常见的策略包括:

ε-贪婪策略(ε-greedy):以概率 ϵ随机选择一个动作,以概率 1−ϵ1 选择当前最优的动作。

软max策略:通过计算动作的概率分布来选择动作,而不是选择最优动作。

三、强化学习调参方法

在强化学习中,调参是训练过程中的重要步骤。以下是一些常见的调参技巧:

3.1 学习率(Learning Rate)

学习率决定了模型每次更新时的步长大小。过小的学习率会导致收敛速度过慢,而过大的学习率则可能导致训练不稳定或无法收敛。常见的做法是采用逐步衰减的学习率,以便在训练后期进行更精细的更新。

3.2 折扣因子(Discount Factor, γ)

折扣因子 γ\gammaγ 决定了未来奖励的权重。在短期任务中,通常选择较大的 γ\gammaγ,而在长期任务中,选择较小的 γ\gammaγ 可以使得模型更多考虑近期的奖励。

3.3 探索参数(Exploration Parameters)

探索策略(如ε-贪婪策略)的参数也需要进行调节。通常,在训练初期,增加探索(例如设置较大的 ϵ\epsilonϵ)可以帮助智能体更全面地了解环境,而在训练后期,减少探索(例如设置较小的 ϵ\epsilonϵ)可以帮助智能体利用已学到的知识。

四、强化学习训练方法

强化学习的训练通常采用以下几种方法:

4.1 基本的 Q-learning 训练方法

Q-learning 是一种无模型的值迭代方法。智能体通过学习 Q 值函数 Q(s,a)Q(s, a)Q(s,a) 来更新策略。训练过程通过以下公式来更新 Q 值:

Q(st,at)=Q(st,at)+α[rt+γmaxa′Q(st+1,a′)−Q(st,at)]Q(s_t, a_t) = Q(s_t, a_t) + \alpha \left[ r_t + \gamma \max_{a’} Q(s_{t+1}, a’) - Q(s_t, a_t) \right]Q(st,at)=Q(st,at)+α[rt+γa′maxQ(st+1,a′)−Q(st,at)]

其中:

sts_tst 是当前状态,

ata_tat 是当前动作,

rtr_trt 是当前奖励,

st+1s_{t+1}st+1 是下一状态,

α\alphaα 是学习率,

γ\gammaγ 是折扣因子。

4.2 深度 Q 网络(DQN)

对于状态和动作空间较大或连续的问题,Q-learning 的表格化方法往往不可行。此时,可以使用深度 Q 网络(DQN)来近似 Q 函数。DQN 使用神经网络来逼近 Q 值函数,从而解决大规模问题。

4.3 Actor-Critic 方法

Actor-Critic 方法结合了值函数和策略优化的优势。Actor 负责选择动作,而 Critic 负责评估动作的价值。两者通过相互作用来不断优化。

五、强化学习完整案例:使用 DQN 玩游戏

5.1 环境准备

我们将使用 OpenAI Gym 提供的 CartPole-v1 环境,该环境要求智能体通过控制杆子平衡一个小车。

bash

复制代码

pip install gym[all] tensorflow

5.2 定义 DQN 模型

DQN 模型包含一个深度神经网络,用于逼近 Q 值函数。

python

**import gymimport numpy as npimport tensorflow as tffrom tensorflow.keras import layers

class DQNAgent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.memory = []

self.gamma = 0.99 # discount factor

self.epsilon = 1.0 # exploration rate

self.epsilon_min = 0.01

self.epsilon_decay = 0.995

self.learning_rate = 0.001

self.model = self._build_model()

def _build_model(self):

model = tf.keras.Sequential([

layers.Dense(24, input_dim=self.state_size, activation='relu'),

layers.Dense(24, activation='relu'),

layers.Dense(self.action_size, activation='linear')

])

model.compile(loss='mse', optimizer=tf.keras.optimizers.Adam(lr=self.learning_rate))

return model

def act(self, state):

if np.random.rand() <= self.epsilon:

return np.random.choice(self.action_size)

q_values = self.model.predict(state)

return np.argmax(q_values[0])

def replay(self, batch_size):

minibatch = np.random.choice(self.memory, batch_size, replace=False)

for state, action, reward, next_state, done in minibatch:

target = reward

if not done:

target += self.gamma * np.max(self.model.predict(next_state)[0])

target_f = self.model.predict(state)

target_f[0][action] = target

self.model.fit(state, target_f, epochs=1, verbose=0)

def remember(self, state, action, reward, next_state, done):

self.memory.append((state, action, reward, next_state, done))

def load(self, name):

self.model.load_weights(name)

def save(self, name):

self.model.save_weights(name)**

5.3 训练 DQN 智能体

python

if __name__ == "__main__":

env = gym.make('CartPole-v1')

state_size = env.observation_space.shape[0]

action_size = env.action_space.n

agent = DQNAgent(state_size, action_size)

episodes = 1000

for e in range(episodes):

state = env.reset()

state = np.reshape(state, [1, state_size])

done = False

time = 0

while not done:

action = agent.act(state)

next_state, reward, done, _ = env.step(action)

next_state = np.reshape(next_state, [1, state_size])

agent.remember(state, action, reward, next_state, done)

state = next_state

time += 1

if len(agent.memory) > 32:

agent.replay(32)

if agent.epsilon > agent.epsilon_min:

agent.epsilon *= agent.epsilon_decay

print(f"Episode {e}/{episodes}, Time: {time}")

agent.save("cartpole-dqn.h5")

5.4 结果展示

通过训练,智能体能够通过不断的学习,成功掌握如何控制小车平衡杆子。在训练过程中,智能体通过与环境的不断交互,不断调整策略,最终实现了一个有效的控制策略。

六、强化学习结果评估

6.1 强化学习的评估标准

6.1.1 累积奖励(Cumulative Reward)

累积奖励是评估强化学习模型最常用的指标之一。它表示智能体在一段时间内所获得的总奖励。通常,在训练过程中,智能体的目标是最大化累积奖励。因此,累积奖励的高低直接反映了智能体的决策策略是否有效。

公式:

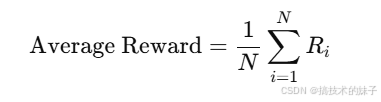

除了累积奖励,平均奖励是另一个常用的评估指标。它通常表示在一定数量的时间步或训练回合中的平均奖励。在训练过程中,智能体的目标是使得平均奖励最大化,而不仅仅是在某一轮获得高奖励。

公式:

其中,N 是评估的回合数,Ri是第 i轮的总奖励。

如果在多个回合中智能体的平均奖励保持稳定并逐步增加,则表明智能体逐渐学会了如何在该环境中做出更好的决策。

6.1.3 回合长度(Episode Length)

回合长度表示智能体在某一回合中与环境交互的时间步数。在强化学习任务中,回合长度可以反映智能体是否能够顺利完成任务。例如,在 CartPole 等任务中,智能体的目标是使杆子尽可能长时间保持平衡。因此,回合长度可以用来评估智能体是否有效地学习到控制策略。

6.1.4 收敛速度(Convergence Speed)

收敛速度表示模型从随机策略到最优策略的学习速度。通常,训练过程中的损失函数或价值函数会逐渐收敛,表示智能体在环境中找到了一个相对稳定的策略。通过观察策略或价值函数的变化趋势,可以评估智能体的学习进程。

收敛速度的评估可以通过绘制奖励曲线来实现。随着训练的进行,智能体的奖励曲线应该趋于平稳,表明它已经接近最优策略。

6.1.5 稳定性(Stability)

稳定性是指智能体在不同时间步、不同回合中获得的奖励波动程度。如果奖励波动较大,则可能表示智能体的学习过程不稳定,策略更新过于剧烈,尚未完全收敛。相反,如果奖励曲线较为平稳,说明智能体已经找到了一个稳定的策略。

6.2 强化学习效果评估方法

6.2.1 可视化评估

可视化是评估强化学习效果的有效手段。通过绘制学习过程中的奖励曲线、状态转移图和智能体的行为路径,可以清楚地了解智能体的学习过程和策略效果。

常见的可视化工具包括:

奖励曲线:绘制每回合的累积奖励或平均奖励,帮助评估智能体在训练过程中的学习进展。

状态-动作值图:对于 Q-learning 等值迭代算法,可以绘制不同状态下的 Q 值,查看智能体在不同状态下采取的行动。

策略演示:通过在环境中可视化智能体的动作,观察智能体在不同状态下的行为模式。

6.2.2 对比实验

通过对比实验,可以更加直观地了解不同策略或算法的表现。例如,可以使用以下几种方法进行对比:

与随机策略对比:使用随机策略来执行任务,比较智能体使用强化学习方法获得的奖励与随机策略获得的奖励差异。

与经典强化学习算法对比:如果使用了某种强化学习算法(如 DQN),可以将其与其他强化学习算法(如 Q-learning、SARSA)进行对比,看看哪些算法表现更优。

与人类表现对比:在一些游戏环境中,可以将智能体的表现与人类玩家的表现进行对比,评估智能体是否能够达到甚至超过人类水平。

6.2.3 长期评估与在线评估

强化学习模型的评估不仅限于离线实验,还可以进行在线评估。在在线评估中,智能体在训练过程中不断与环境交互并进行实时更新。这可以反映智能体在不断变化的环境下的适应能力。

长期评估:观察智能体在长时间运行中的表现是否稳定。

在线评估:在训练过程中周期性地评估智能体的性能,以验证其是否能够在不断变化的环境中保持良好的决策能力。

6.3 常用评估指标总结

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)