DEIMv2:实时目标检测遇见DINOv3

论文证明了像DINOv3这样的前沿基础模型可以通过精巧的设计,在不牺牲速度的前提下赋能实时视觉任务,为相关研究提供了新范式。

💡💡💡这篇论文的核心贡献,在于它成功地将强大的视觉基础模型DINOv3的特性,高效地适配到了对计算资源敏感的实时目标检测任务中,推出了一系列称为DEIMv2的模型,在精度和效率的平衡上取得了突破

-

成功适配DINOv3:创新性地提出了空间调谐适配器(STA),巧妙地解决了DINOv3单尺度输出与目标检测所需多尺度特征之间的矛盾,将其强大的语义表征能力高效地引入实时检测任务。

-

构建统一模型家族:推出了覆盖从GPU到移动端的8个不同尺度的DEIMv2模型(X/L/M/S/Nano/Pico/Femto/Atto),为各种资源限制的场景提供了高性能解决方案。

-

实现性能新突破:在COCO数据集上取得了里程碑式的成果。其中,DEIMv2-S成为首个参数量低于1000万却突破50 AP的模型;DEIMv2-X以更少的参数量达到了更高的精度,显著提升了实时检测的精度-效率边界。

博主简介

AI小怪兽,YOLO骨灰级玩家,1)YOLOv5、v7、v8、v9、v10、11、v12、v13优化创新,轻松涨点和模型轻量化;2)目标检测、语义分割、OCR、分类等技术孵化,赋能智能制造,工业项目落地经验丰富;

原创自研系列, 2024、25年计算机视觉顶会创新点

应用系列篇:

23、24年最火系列,加入24年改进点内涵100+优化改进篇,涨点小能手,助力科研,好评率极高

DEIMv2原理介绍

论文:https://arxiv.org/pdf/2509.20787

摘要:得益于Dense O2O(密集一对一匹配)和MAL(多尺度对齐损失)的简洁性与高效性,DEIM已成为实时DETR系列的主流训练框架,其性能显著超越YOLO系列。本研究通过引入DINOv3特征对该框架进行扩展,推出了DEIMv2。DEIMv2涵盖从X到Atto共八种规模模型,适配GPU、边缘计算及移动端部署场景。针对X、L、M、S规格变体,我们采用DINOv3预训练/蒸馏主干网络,并引入空间调谐适配器(STA)。该适配器能高效将DINOv3的单尺度输出转换为多尺度特征,并通过补充细粒度细节来增强强语义表征,从而提升检测性能。对于超轻量模型(Nano、Pico、Femto、Atto),我们采用经过深度和宽度剪枝的HGNetv2以满足严苛的资源限制。结合简化解码器与升级版Dense O2O,这种统一设计使DEIMv2在多样化场景中实现卓越的性能-成本平衡,创造了新的性能纪录。值得注意的是,最大规格模型DEIMv2-X仅用5030万参数量即达成57.8 AP,优于此前需超过6000万参数仅获得56.5 AP的同规模模型。在紧凑型侧,DEIMv2-S成为首个参数量低于1000万(971万)却在COCO数据集上突破50 AP里程碑的模型,达到50.9 AP。即便是仅150万参数的超轻量级DEIMv2-Pico,也实现了38.5 AP——与参数量多出约50%的YOLOv10-Nano(230万参数)性能持平。

1. 引言

实时目标检测 [6, 18, 22, 29] 是许多实际应用中的关键组成部分,包括自动驾驶 [11]、机器人技术 [16] 和工业缺陷检测 [8]。在检测性能和计算效率之间取得良好平衡仍然是一个关键挑战,特别是对于适用于边缘和移动设备的轻量级模型而言。

在主流实时目标检测器中,基于 DETR 的方法因其端到端设计和 Transformer 所赋能的高容量而吸引了越来越多的关注,实现了更优的权衡。在此范式下,DEIM 已成为一个强大的训练框架,它推动了实时 DETR 的发展,并带来了该领域的领先模型。与此同时,DINOv3 [21] 已在多种视觉任务中展现出强大的特征表示能力。然而,其在实时目标检测方面的潜力尚未得到充分探索。

本工作中,我们介绍了 DEIMv2,这是一个基于我们先前 DEIM [7] pipeline 并利用 DINOv3 [21] 特征增强的实时目标检测器。DEIMv2 为其最大变体(L 和 X 尺寸)采用了官方的 DINOv3 预训练主干网络(ViT-Small 和 ViT-Small+)以最大化特征丰富性,而其 S 和 M 变体则利用了从 DINOv3 蒸馏得到的 ViT-Tiny 和 ViT-Tiny+ 主干网络,仔细平衡了性能与效率。为应对超轻量场景,我们进一步引入了四个专用变体:Nano、Pico、Femto 和 Atto,将 DEIMv2 的可扩展性延伸至广泛的计算预算范围。

为了在实时约束下更好地利用 DINOv3 在大规模数据上预训练所得的强大特征表示,我们设计了空间调谐适配器(STA)。STA 与 DINOv3 并行工作,以无参数的方式高效地将其单尺度输出转换为目标检测所需的多尺度特征。同时,它对输入图像进行快速下采样,以提供具有极小感受野的细粒度、多尺度细节特征,从而对 DINOv3 的强语义形成补充。

我们借鉴 Transformer 领域的进展,进一步简化了解码器。具体来说,我们用 SwishFFN [20] 和 RMSNorm [27] 取代了传统的 FFN 和 LayerNorm,这两者已被证明是高效的且不会显著影响性能。我们还注意到,目标查询位置在迭代优化过程中变化极小,这促使我们在所有解码器层之间共享查询位置嵌入。除此之外,我们通过引入对象级 Copy Blend 数据增强来增强 Dense O2O,这增加了有效的监督并进一步提高了模型性能。

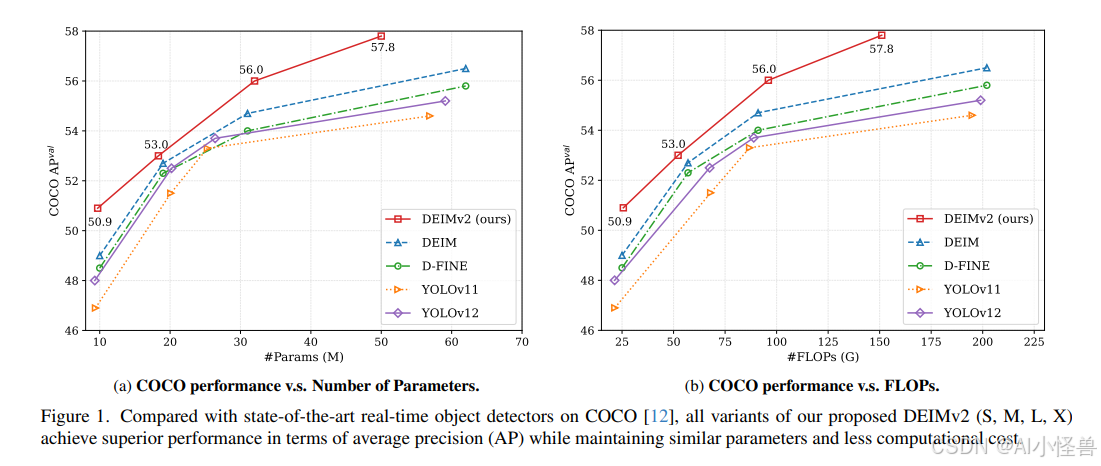

在 COCO [12] 数据集上进行的大量实验表明,DEIMv2 在多个模型尺度上均实现了最先进的性能,如图 1 所示。尽管设计简洁,DEIMv2 系列模型仍表现出强大的性能。例如,我们最大的变体 DEIMv2-X 仅用 5030 万参数就在 COCO 上达到了 57.6 AP,超越了之前需要超过 6000 万参数却仅获得 56.5 AP 的最佳 X 尺度检测器 DEIM-X。在较小尺寸端,DEIMv2-S 树立了一个显著的里程碑,成为首个参数量少于 1000 万却超过 50 AP 的模型,凸显了我们的设计在紧凑尺度上的有效性。此外,我们的超轻量级 DEIMv2-Pico 仅用 150 万参数就达到了 38.5 AP,与 YOLOv10-Nano(230 万参数)的性能持平,同时将参数量减少了约 50%,从而在极端轻量级领域重新定义了效率-精度边界。

我们的工作凸显了如何将 DINOv3 [21] 特征有效地适配用于实时目标检测,并提供了一个涵盖从超轻量级到高性能模型的通用框架。据我们所知,这是实时目标检测领域首个能同时应对如此广泛部署场景的工作。

本研究的主要贡献总结如下:

-

我们提出了 DEIMv2,它提供八种模型尺寸,覆盖 GPU、边缘和移动端部署。

-

对于较大模型,我们利用 DINOv3 获取强语义特征,并引入 STA 将其高效集成到实时目标检测中。

-

对于超轻量级模型,我们利用专家知识有效剪枝 HGNetv2-B0 的深度和宽度,以满足严格的计算限制。

-

除了主干网络,我们进一步简化了解码器并升级了 Dense O2O,从而将性能边界推向更远。

-

最后,我们在 COCO 数据集上证明,DEIMv2 在所有资源设置下均优于现有的最先进方法,建立了新的 SOTA 结果。

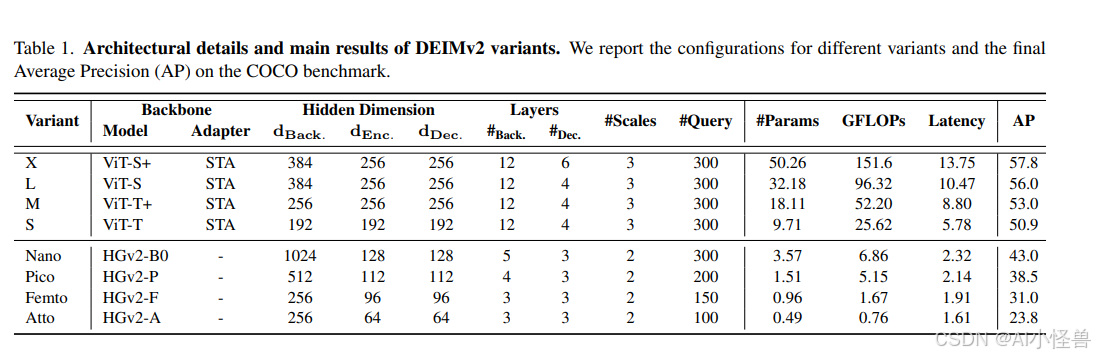

2. 方法

整体架构:我们的整体架构遵循 RT-DETR [14] 的设计,包含一个主干网络、一个混合编码器和一个解码器。如表 1 所示,对于主流变体 X、L、M 和 S,主干网络基于 DINOv3 并辅以我们提出的空间调谐适配器(STA),而其余变体则使用 HGNetv2 [1]。来自主干网络的多尺度特征首先由编码器处理,以产生初始检测结果并选择前 K 个候选边界框。解码器则迭代地优化这些候选框以生成最终预测。

基于 ViT 的变体:对于较大的 DEIMv2 变体(S、M、L、X),我们围绕 Vision Transformer [3](ViT)系列精心设计了主干网络,以平衡模型容量和效率。对于 L 和 X 变体,我们利用了两个公开的 DINOv3 模型 [21]:ViT-Small 和 ViT-Small+,它们通过 12 层网络和 384 维隐藏大小提供了强大的语义表示。对于更轻量的 S 和 M 变体,我们直接从 ViT-Small DINOv3 蒸馏得到紧凑的主干网络 ViT-Tiny 和 ViT-Tiny+,保持了 12 层的深度,同时将隐藏层维度分别降至 192 和 256。这种设计实现了从 S → M → L → X 的平滑缩放路径,确保每个变体在适应不同效率需求的同时保持有竞争力的准确度。

基于 HGNetv2 的变体:由百度 PaddlePaddle 团队开发的 HGNetv2 [1] 因其高效性而被广泛用于实时 DETR 框架中,例如 D-FINE [17] 就采用了完整的 HGNetv2 系列作为其主干网络。在我们的超轻量级 DEIMv2 模型(Nano、Pico、Femto 和 Atto)中,我们同样基于 HGNetv2-B0 构建,但逐步剪枝其深度和宽度以满足不同的参数预算。具体来说,Pico 主干网络移除了 B0 的第四阶段,仅保留最大至 1/16 尺度的输出。Femto 则进一步将 Pico 最后阶段的块数从两个减少到一个。Atto 更进一步,将最后一个块的通道数从 512 缩减至 256。

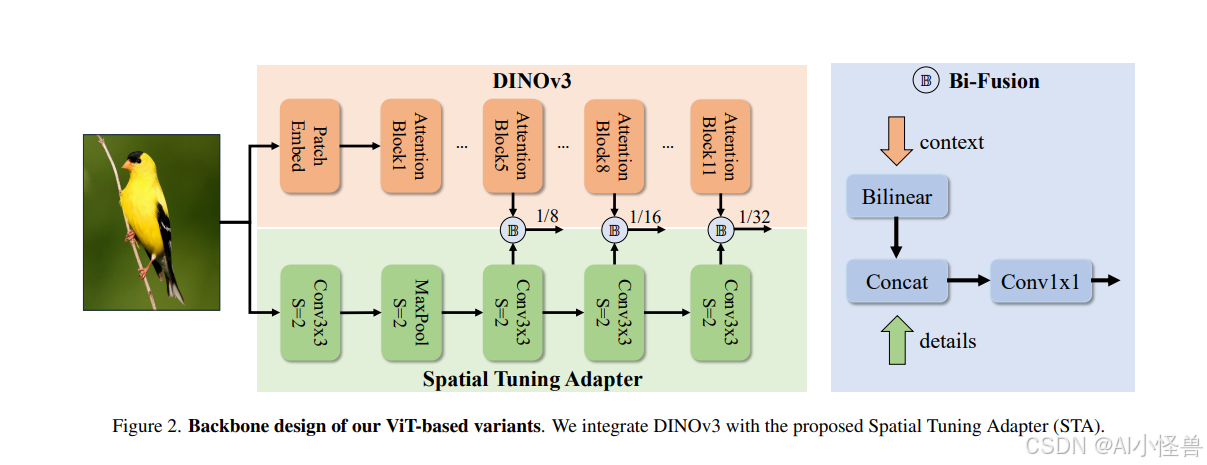

空间调谐适配器(STA):为了更好地使 DINOv3 特征适应实时目标检测,我们提出了空间调谐适配器(STA),如图 2 所示。STA 是一个全卷积网络,它集成了一个用于提取细粒度多尺度细节的超轻量级前馈网络,以及一个用于进一步增强 DINOv3 特征表示的 Bi-Fusion 算子。

DINOv3 基于 ViT 主干网络,天然产生单尺度(1/16)的密集特征。然而,在目标检测中,物体的尺寸变化很大,多尺度特征是提高性能最有效的方法之一。为此,ViTDet [10] 引入了 Feature2Pyramid 模块,该模块使用反卷积从最终的 ViT 输出生成多尺度特征。相比之下,我们的 STA 更加简单:我们直接通过无参数的双线性插值,将来自几个 ViT 块(例如,第 5、8、11 块)的 1/16 尺度特征调整到多个尺度。这些多尺度特征通过由 1×1 卷积和一个旨在提取细粒度细节以补充 DINOv3 输出特征的超轻量级 CNN 所组成的 Bi-Fusion 算子得到进一步增强。这种设计在效率和精度之间取得了极佳的平衡,使其非常适合实时检测。

高效解码器:我们通过融入 Transformer 领域广泛采用的几种面向效率的技术,增强了标准的可变形注意力解码器 [31],实现了优越的性能-成本权衡。具体来说,我们集成了 SwiGLUFFN [20] 以增强非线性表示能力,并采用 RMSNorm [27] 来稳定并高效地加速训练。我们注意到目标查询位置在迭代优化过程中变化极小,因此进一步提出在所有解码器层之间共享单一的位置嵌入,从而消除了冗余计算。

增强的 Dense O2O:在我们之前的 DEIM [7] 中,我们提出了 Dense O2O,它增加了每张训练图像中的物体数量以提供更强的监督,从而改善收敛性和性能。其有效性最初通过使用 Mosaic 和 MixUp [28] 等图像级增强技术得到了验证。在 DEIMv2 中,我们在物体级别进一步探索 Dense O2O,采用了 Copy-Blend 方法,该方法添加不带背景的新物体。与完全覆盖目标区域的 Copy-Paste [4] 不同,Copy-Blend 将新物体与图像进行混合,这更符合我们的场景并能持续提升性能。

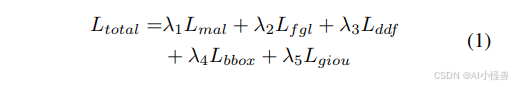

训练设置与损失函数:我们的训练策略遵循 DEIM [7],这是一个为快速收敛和高性能而设计的基础框架。总体优化目标是由五个组成部分的加权和:可匹配性感知损失(MAL)[7]、细粒度定位损失(FGL)[17]、解耦蒸馏焦点损失(DDF)[17]、边界框损失(L1)和 GIoU 损失 [19]。总损失定义为:

Ltotal = λ1LMAL + λ2LFGL + λ3LDDF + λ4LL1 + λ5LGIoU,所有权重在所有实验中设置为 λ1 = 1.0, λ2 = 0.15, λ3 = 1.5, λ4 = 5, λ5 = 2。

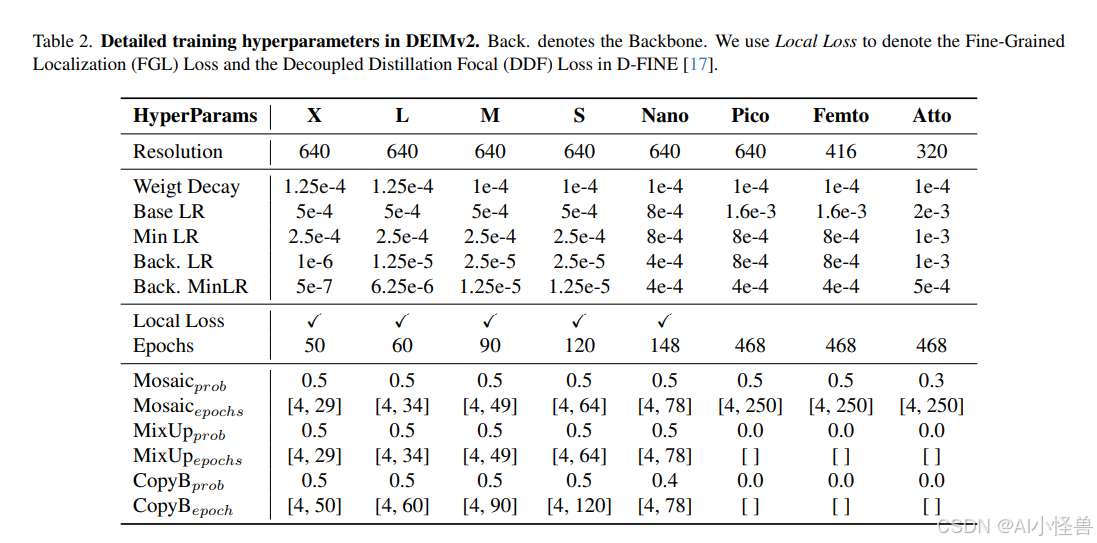

我们在表 2 中总结了训练超参数,包括输入分辨率、学习率、训练周期和 Dense O2O 设置。一个有趣的观察是,对超轻量级模型应用 FGL 和 DDF 损失会降低性能。我们将其归因于它们有限的能力和固有的较弱基线精度,这降低了自蒸馏的有效性。因此,我们在训练 Pico、Femto 和 Atto 变体时排除了这两个组成部分(即局部损失)。

3. 实验

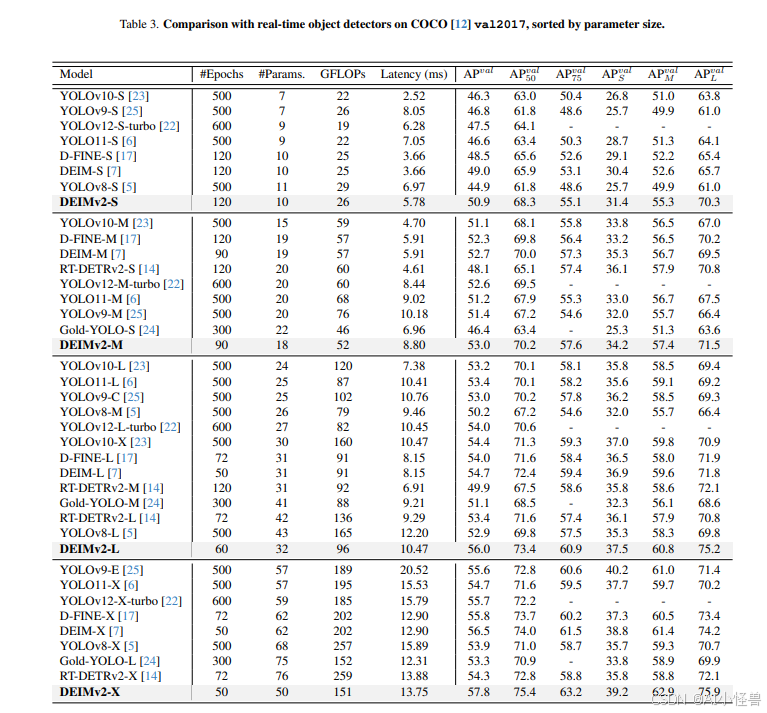

与最先进实时目标检测器的比较:表 3 总结了 DEIMv2 在 S、M、L 和 X 变体上的性能,表明其相较之前的先进检测器有显著提升。例如,最大的变体 DEIMv2-X 仅以约 5000 万参数和 151 GFLOPs 的计算量达到了 57.8 AP,超越了之前最佳的 DEIM-X(56.5 AP,需要 6200 万参数和 202 GFLOPs)。这表明 DEIMv2 能够以更少的参数和更低的计算成本提供更优的精度。在较小尺寸端,DEIMv2-S 树立了一个新的里程碑,成为首个在 COCO 数据集上参数量少于 1000 万却突破 50 AP 阈值的模型,仅以 1100 万参数和 26 GFLOPs 实现了 50.9 AP。这相较于之前的 DEIM-S(49.0 AP,1000 万参数)是一个明显的进步,而模型大小几乎相同。虽然基于 CNN 的主干网络通常对硬件更友好,但我们基于 ViT 的主干网络实现了参数更少、FLOPs 更低的轻量级设计,提供了更好的可扩展性和部署灵活性。值得注意的是,所提方法的延迟尚未优化。像 Yolov12 [22] 中采用的 Flash Attention [2] 等技术可以进一步加速推理。总体而言,降低的 FLOPs 凸显了基于 ViT 的主干网络在经过适当优化后实现低延迟性能的潜力。

有趣的是,在参数和 FLOPs 预算相近的情况下,将基于 DINOv3 的 DEIMv2 模型与之前的 DEIM 对应模型进行比较时,精度的提升主要来源于对中型和大型物体检测的改进,而小物体检测性能基本保持不变。例如,DEIMv2-S 实现了 55.3 APM 和 70.3 APL,明显超过了 DEIM-S(52.6 APM 和 65.7 APL),但小物体的得分几乎相同(31.4 vs. 30.4 APS)。对于更大的模型也观察到类似趋势:DEIMv2-X 将 APM 从 61.4 提升至 62.8,APL 从 74.2 提升至 75.9,而其小物体 AP(39.2)仍与 DEIM-M(38.8)接近。这些结果表明,DEIMv2 的主要优势在于增强了对中型和大型物体的表示和检测能力,而小物体检测在不同尺度上仍然是一个挑战。这一观察进一步证实了 DINOv3 擅长捕获强大的全局语义,但在表示细粒度细节方面能力有限。因此,探索如何更好地将 DINOv3 特征集成到实时检测器中是未来工作的一个有趣方向。

与有竞争力的超轻量目标检测器的比较:DEIMv2 的超轻量变体也表现出强劲的性能,总结在表 4 中。DEIMv2-Atto 仅用 49 万参数就实现了与 NanoDet-M 相当的性能,尽管其尺寸小得多。类似地,DEIMv2-Pico 达到了与 YOLOv10-N [23] 同等的性能,而所需参数却不到后者的一半。这些结果突显了 DEIMv2 在极端紧凑模型下的有效性,并强调了其适用于在资源受限的边缘设备上部署。

4. 结论

在本报告中,我们介绍了 DEIMv2,这是一种新一代实时目标检测器,它将 DINOv3 的强大语义表示与我们轻量级的 STA 相结合。通过精心设计和尺度缩放,DEIMv2 在全系列模型尺寸上均实现了最先进的性能。在高端,DEIMv2-X 以显著少于之前大型检测器的参数实现了 57.8 AP。在紧凑端,DEIMv2-S 是同类尺寸中首个超越 50 AP 的模型,而超轻量级的 DEIMv2-Pico 在使用参数减少 50% 以上的情况下,性能与 YOLOv10-N 持平。总之,这些结果表明 DEIMv2 不仅高效,而且具有高度的可扩展性,提供了一个能推进精度-效率边界的统一框架。这种多功能性使 DEIMv2 非常适合在各种场景中部署,从资源受限的边缘设备到高性能检测系统,为在实际应用中更广泛地采用实时检测铺平了道路。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)