小目标检测论文和代码汇总

code: https://github.com/obss/sahi概要:这篇论文提出了一种名为切片辅助超推理(SAHI) 的通用框架,通过切片辅助微调 和切片辅助推理 两种方法,显著提升了小目标检测的性能。其核心贡献在于:无需修改现有检测器结构,即可通过图像切片与重叠推理策略有效增强小目标的检测能力,并在VisDrone和xView数据集上实现了最高达14.5%的平均精度提升。该方法已集成至主流

2022

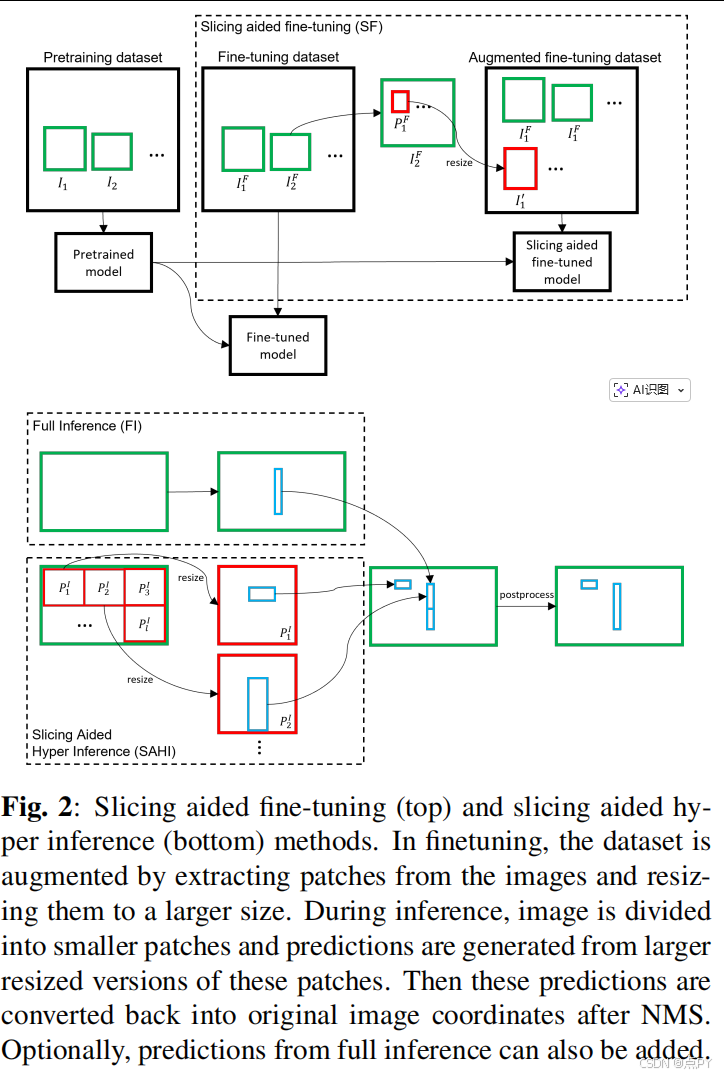

Slicing Aided Hyper Inference and Fine-tuning for Small Object Detection

code: https://github.com/obss/sahi

概要:这篇论文提出了一种名为切片辅助超推理(SAHI) 的通用框架,通过切片辅助微调 和切片辅助推理 两种方法,显著提升了小目标检测的性能。其核心贡献在于:无需修改现有检测器结构,即可通过图像切片与重叠推理策略有效增强小目标的检测能力,并在VisDrone和xView数据集上实现了最高达14.5%的平均精度提升。该方法已集成至主流检测框架如Detectron2、MMDetection和YOLOv5,具有良好的通用性和易用性。

2024

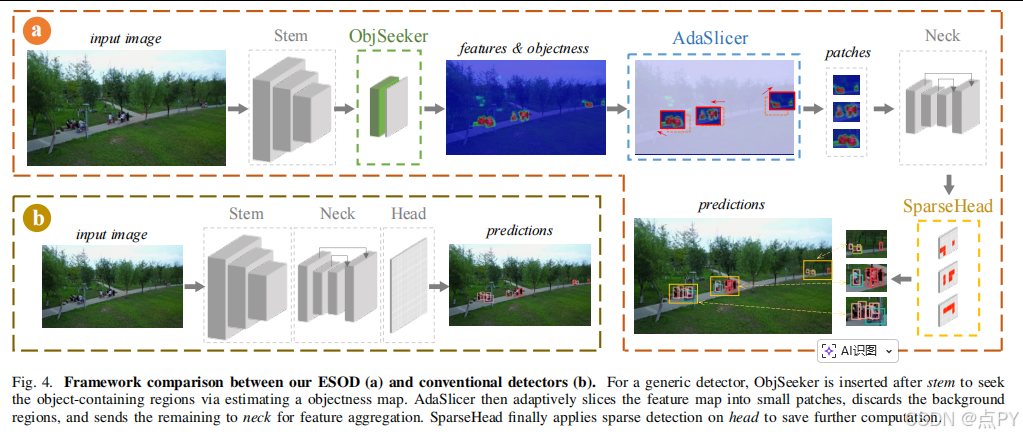

ESOD: Efficient Small Object Detection on High-Resolution Images

code: https://github.com/alibaba/esod

概要:ESOD 通过在特征层面进行目标定位与切片,并结合稀疏检测头,有效避免了高分辨率图像中大量背景区域上的冗余计算,显著提升了小目标检测的效率和可扩展性。该方法不仅适用于 CNN 架构,也能适配 ViT,并在多个数据集上以更低的计算成本实现了显著优于现有方法的检测精度。

2025

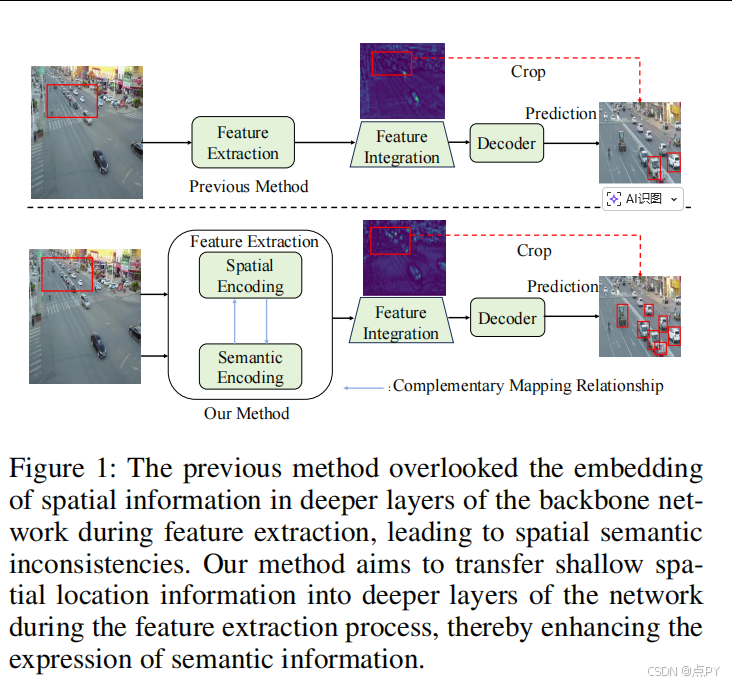

FBRT-YOLO: Faster and Better for Real-Time Aerial Image Detection

code: https://github.com/galaxy-oss/FCM.git

概要: 这篇论文提出了一种名为 FBRT-YOLO 的实时航拍图像检测模型,旨在解决在资源受限的嵌入式设备上实现高效、准确的小目标检测的难题。传统检测器在处理高分辨率航拍图像时,常因小目标信息在深层网络中丢失、语义与空间信息不匹配以及模型冗余计算量大等问题导致性能下降。FBRT-YOLO 通过引入两个轻量化模块——特征互补映射模块(FCM) 和多核感知单元(MKP),分别增强了深层网络中空间位置信息的保留能力和多尺度目标的感知能力,同时通过结构优化显著减少了参数和计算量。实验在VisDrone、UAVDT和AI-TOD等主流航拍数据集上表明,该模型在保持高推理速度的同时,显著提升了检测精度,实现了精度与效率的更好平衡。

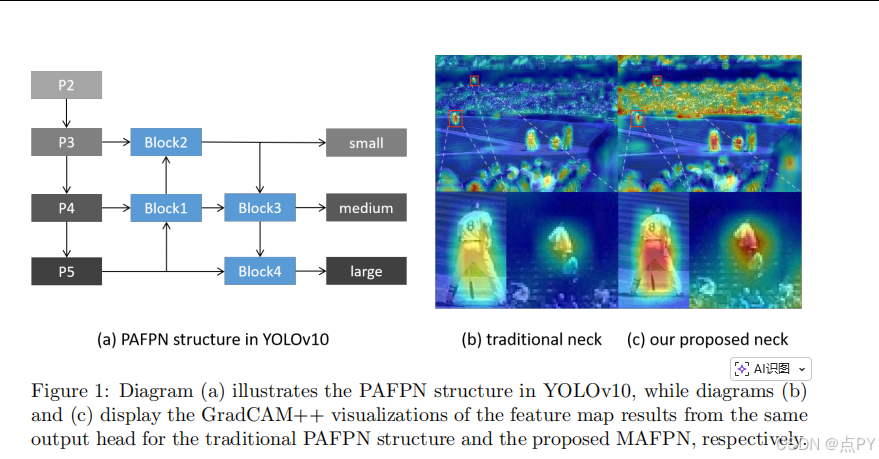

MHAF-YOLO: Multi-Branch Heterogeneous Auxiliary Fusion YOLO for accurate object detection

code: https://github.com/yang-0201/MHAF-YOLO

概要:MHAF-YOLO 通过MAFPN实现深浅层特征的充分融合,借助RepHMS提升特征提取的多样性与效率,并利用GHFKS机制自适应扩展感受野,从而在保持高参数利用率的前提下,显著提升了多尺度目标(尤其是小目标)的检测精度。该模型在COCO、VOC、DOTA等多个数据集上实现了SOTA性能,并在实例分割与旋转目标检测任务中表现出优秀的泛化能力。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)