脑电情感识别SEED-IV深度学习代码数据下载

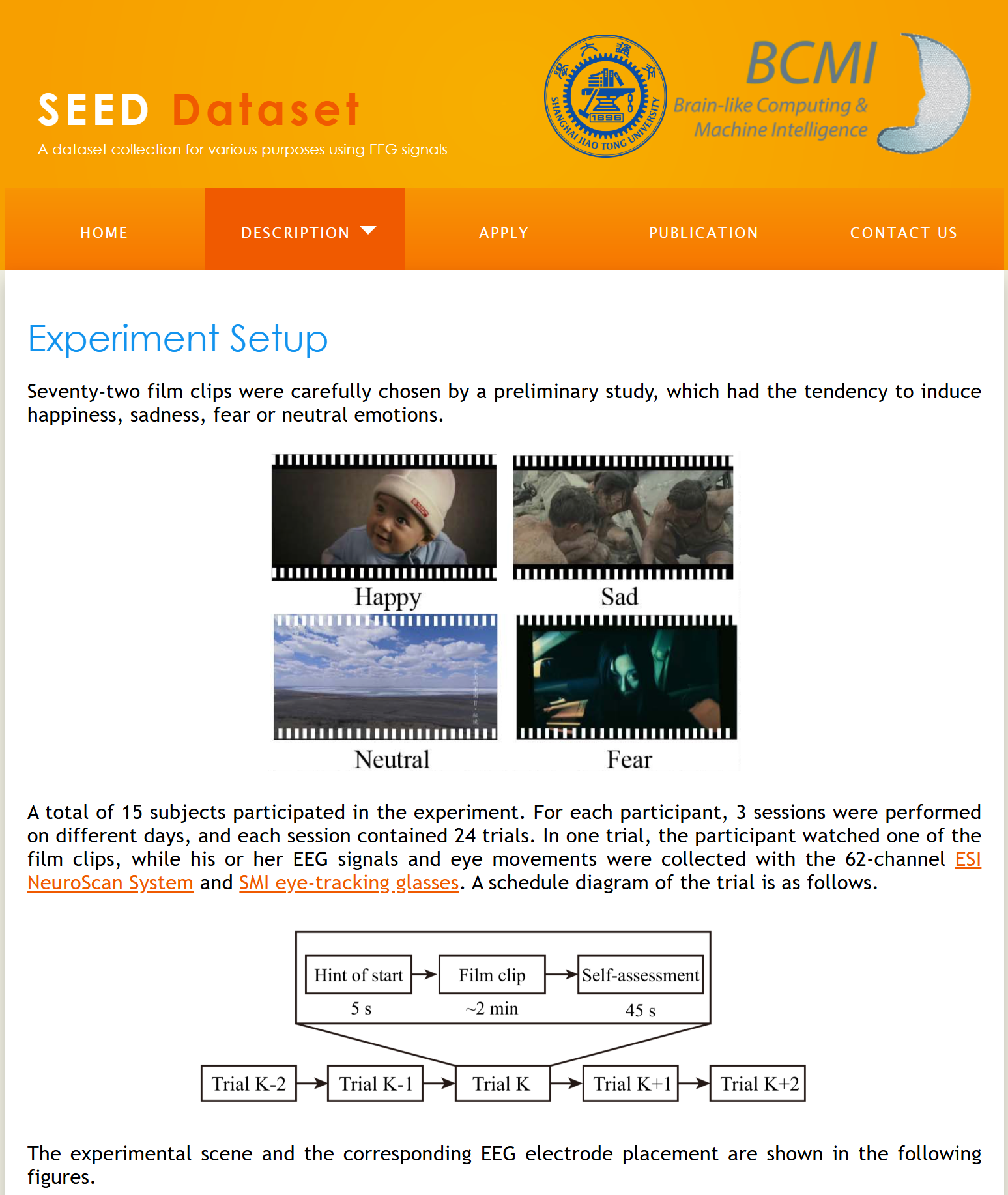

项目内容任务多类别情绪识别(4 类)情绪类别喜悦(Happy)、愤怒(Angry)、恐惧(Fear)、悲伤(Sad)被试人数15 名受试者采集设备EEG:62 通道(由 ESI NeuroScan System 采集)Eye-tracking:Tobii X120采样率EEG:1000Hz时长每个被试观看 72 个情绪诱导视频,每个视频约 1 分钟实验次数每位受试者重复实验 3 次(跨天)标签来

官网:https://bcmi.sjtu.edu.cn/~seed/seed-iv.html

论文:https://ieeexplore.ieee.org/abstract/document/8283814

代码数据下载:https://gitee.com/CodeStoreHub/Emotion-Recognition-Dataset

数据集介绍

| 项目 | 内容 |

|---|---|

| 任务 | 多类别情绪识别(4 类) |

| 情绪类别 | 喜悦(Happy)、愤怒(Angry)、恐惧(Fear)、悲伤(Sad) |

| 被试人数 | 15 名受试者 |

| 采集设备 | EEG:62 通道(由 ESI NeuroScan System 采集)Eye-tracking:Tobii X120 |

| 采样率 | EEG:1000Hz |

| 时长 | 每个被试观看 72 个情绪诱导视频,每个视频约 1 分钟 |

| 实验次数 | 每位受试者重复实验 3 次(跨天) |

| 标签来源 | 视频情绪标签、主观评价 |

代码介绍

🎯 研究目标概述

该方法旨在通过构建动态脑区连接图,利用图神经网络提取脑电图(EEG)中的空间和时间特征,实现多类别情绪分类。DGCNN 能有效建模大脑皮层之间的非欧几里得连接关系,提升识别准确性。

🧠 背景知识

EEG 情绪识别挑战:

-

EEG 数据高噪声、时变性强;

-

脑电通道与脑区之间的连接具有图结构特征;

-

传统 CNN 或 RNN 难以捕捉非结构化信号之间的跨通道依赖关系。

🔧 方法框架概览(DGCNN for EEG)

1. 原始输入

-

输入为多通道 EEG 信号,通常形状为:

EEG shape: (channels, time steps)

例如:(62, 128)表示 62 个通道,128 个时间点。

2. 动态图构建(每层)

-

每层根据当前特征计算通道之间的欧氏/相关性距离,构建 k-NN 图:

Grapht=knn(xi,xj),i,j∈channels\text{Graph}_t = \text{knn}(x_i, x_j), \quad i,j \in \text{channels}Grapht=knn(xi,xj),i,j∈channels -

图的邻接矩阵随着每层特征演化而变化,体现神经动态关系重构。

3. EdgeConv 模块(图卷积)

EdgeConv 特征提取方式如下:

h(xi,xj)=MLP(xi,xj−xi)h(x_i, x_j) = \text{MLP}(x_i, x_j - x_i)h(xi,xj)=MLP(xi,xj−xi)

通过聚合邻居节点的差值特征,再经 MLP 提取局部脑区动态连接特征。

4. 全局聚合与分类

经过多层 EdgeConv 后,通过最大池化或注意力汇聚全局特征,再通过全连接层进行情绪分类(如:4类 SEED-IV)。

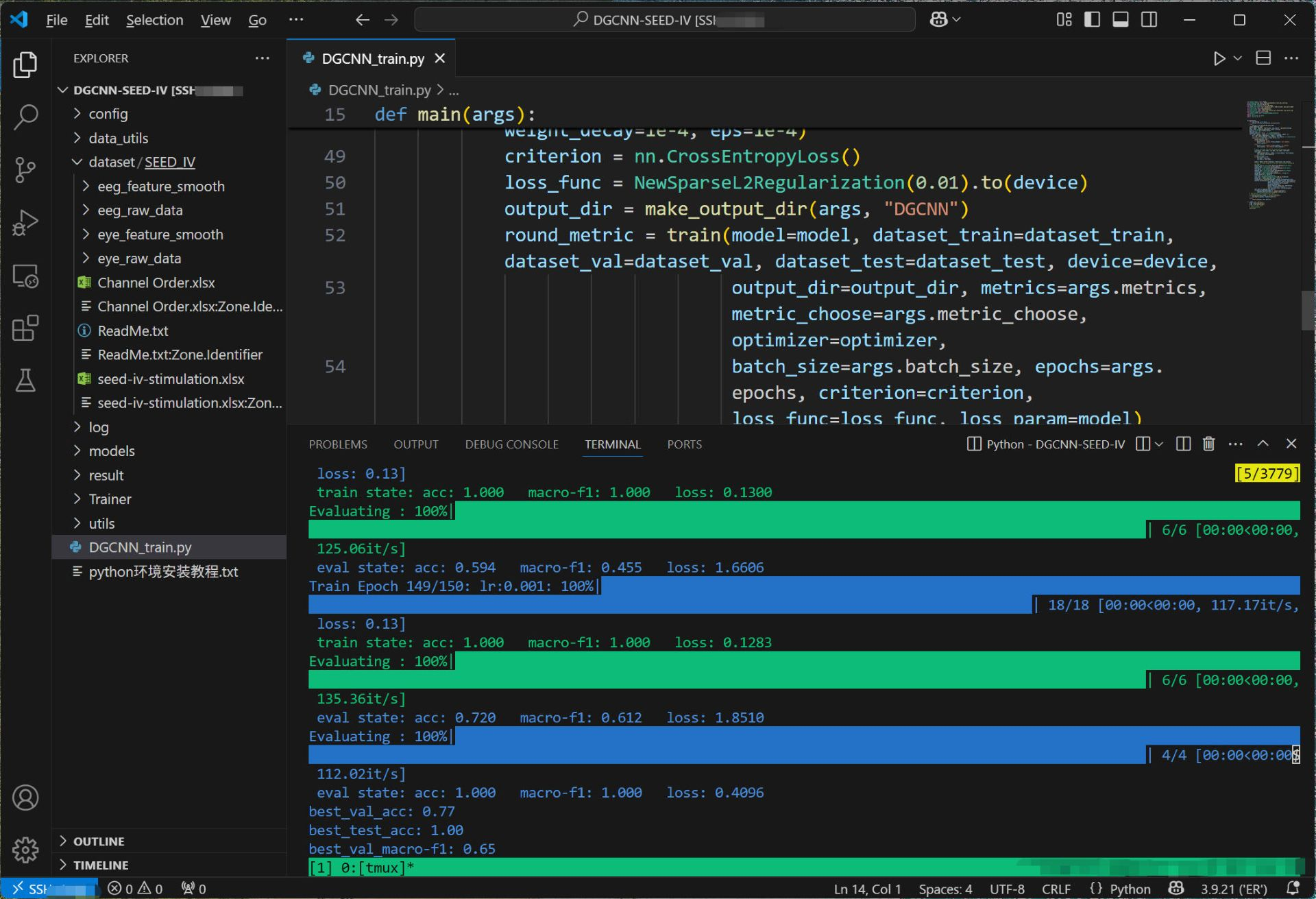

📈 实验效果

在SEED-IV数据集上,DGCNN 架构通常能在以下方面 outperform baseline:

-

情绪分类准确率提高 3%–10%;

-

更强的跨被试泛化能力;

-

脑区连接解释性更强。

代码预览

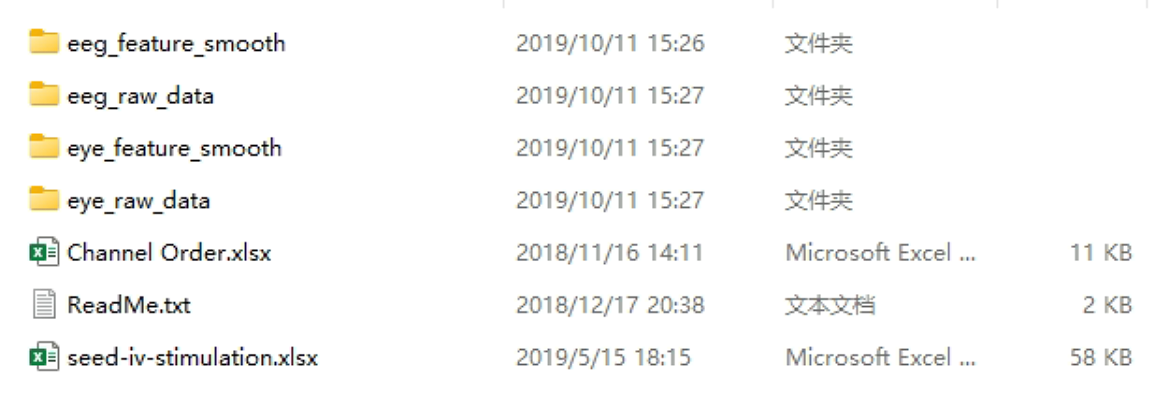

数据预览

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)