DeepSeek算力需求全解析:不同版本需要多少显存?

DeepSeek的每一次模型升级,都是对计算资源的极限挑战。,DeepSeek-R1-Distill-Qwen-1.5B 仅需。,专为高性能计算、大规模数据处理而设计。DeepSeek模型的规模越大,显存需求就越高。对于参数规模较大的DeepSeek模型,建议使用。今天,我们就来详细解析,让你一目了然!✅ 可在有限资源下运行,仍具备较强能力。目前,DeepSeek主要推出了。✅ 适用于小规模AI训

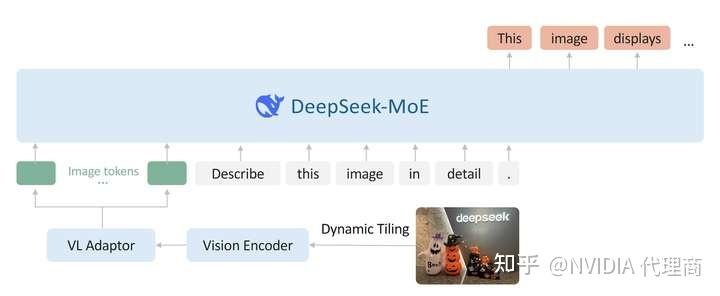

最近,AI圈子里最火的关键词非DeepSeek莫属。作为开源AI模型,DeepSeek的强大性能和广泛应用,让它迅速成为科技行业关注的焦点。无论是大模型训练、高性能计算,还是智能化数据处理,DeepSeek都展现出了卓越的实力。

但你是否想过,不同版本的DeepSeek模型到底需要多少算力支撑? 今天,我们就来详细解析,让你一目了然!

DeepSeek开放了哪些模型?

目前,DeepSeek主要推出了DeepSeek-R1和DeepSeek-V3两个核心开源模型:

1. DeepSeek-R1

DeepSeek-R1 是大规模预训练模型,专为高性能计算、大规模数据处理而设计。它的参数规模从1.5B(15亿)到671B(6710亿),适用于大模型训练、复杂推理任务等高算力需求场景。

特点:

✅ 高精度、高复杂度

✅ 适用于企业级AI训练和科研机构

✅ 需要强大的算力支持

2. DeepSeek-V3

DeepSeek-V3 是一款轻量化模型,优化了计算需求,兼顾高效能与低成本,适合中小企业或个人开发者。

特点:

✅ 算力需求较低,更易部署

✅ 适用于小规模AI训练和推理

✅ 可在有限资源下运行,仍具备较强能力

DeepSeek模型对显存(VRAM)的需求

DeepSeek模型的规模越大,显存需求就越高。从1.5B到671B,显存需求增长是指数级的。以下是各版本的参数规模与显存需求:

| 模型名称 | 参数量(B) | 最低显存需求(GB) |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | 1.5B | ~3.9GB |

| DeepSeek-R1-Distill-Qwen-7B | 7B | ~18GB |

| DeepSeek-R1-Distill-Llama-8B | 8B | ~21GB |

| DeepSeek-R1-Distill-Qwen-14B | 14B | ~36GB |

| DeepSeek-R1-Distill-Qwen-32B | 32B | ~82GB |

| DeepSeek-R1-Distill-Llama-70B | 70B | ~181GB |

| DeepSeek-R1 | 671B | ~1,543GB |

对于小型AI推理,DeepSeek-R1-Distill-Qwen-1.5B 仅需几GB显存即可运行,但如果想驾驭DeepSeek-R1 671B,则至少需要超大算力支持,显存需求高达 1,543GB!

不同规模的DeepSeek模型适用于哪些场景?

选择适合的DeepSeek版本,取决于你的业务需求:

✅ 小规模模型(1.5B - 8B)

适合AI初创企业、个人开发者、实验性AI项目,能够在消费级显卡或低配GPU上运行。

✅ 中等规模模型(14B - 32B)

适用于企业级AI推理、NLP任务、计算机视觉,需要更大算力支持。

✅ 大规模模型(70B以上)

适用于科研机构、AI实验室、大型企业,通常需要分布式GPU计算。

对于参数规模较大的DeepSeek模型,建议使用多GPU服务器,采用NVLink、InfiniBand等高速互联技术,实现算力扩展,保障大模型的高效训练和推理。

想了解更多DeepSeek算力需求?关注我!

DeepSeek的每一次模型升级,都是对计算资源的极限挑战。如果你正在寻找适配DeepSeek的GPU服务器,或想要构建高性能AI计算环境,关注我的账号,了解最新DeepSeek算力需求,抢占AI技术先机!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)