【Logit模型、Agent-Logit模型、生成agent复杂网络】基于DQN深度强化学习的交通费研究(Matlab代码实现)

💥💥💞💞❤️❤️💥💥博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。⛳️行百里者,半于九十。📋📋📋🎁🎁🎁。

💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

基于Logit模型、Agent-Logit模型与生成Agent复杂网络的DQN交通系统优化

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

基于Logit模型、Agent-Logit模型与生成Agent复杂网络的DQN交通系统优化

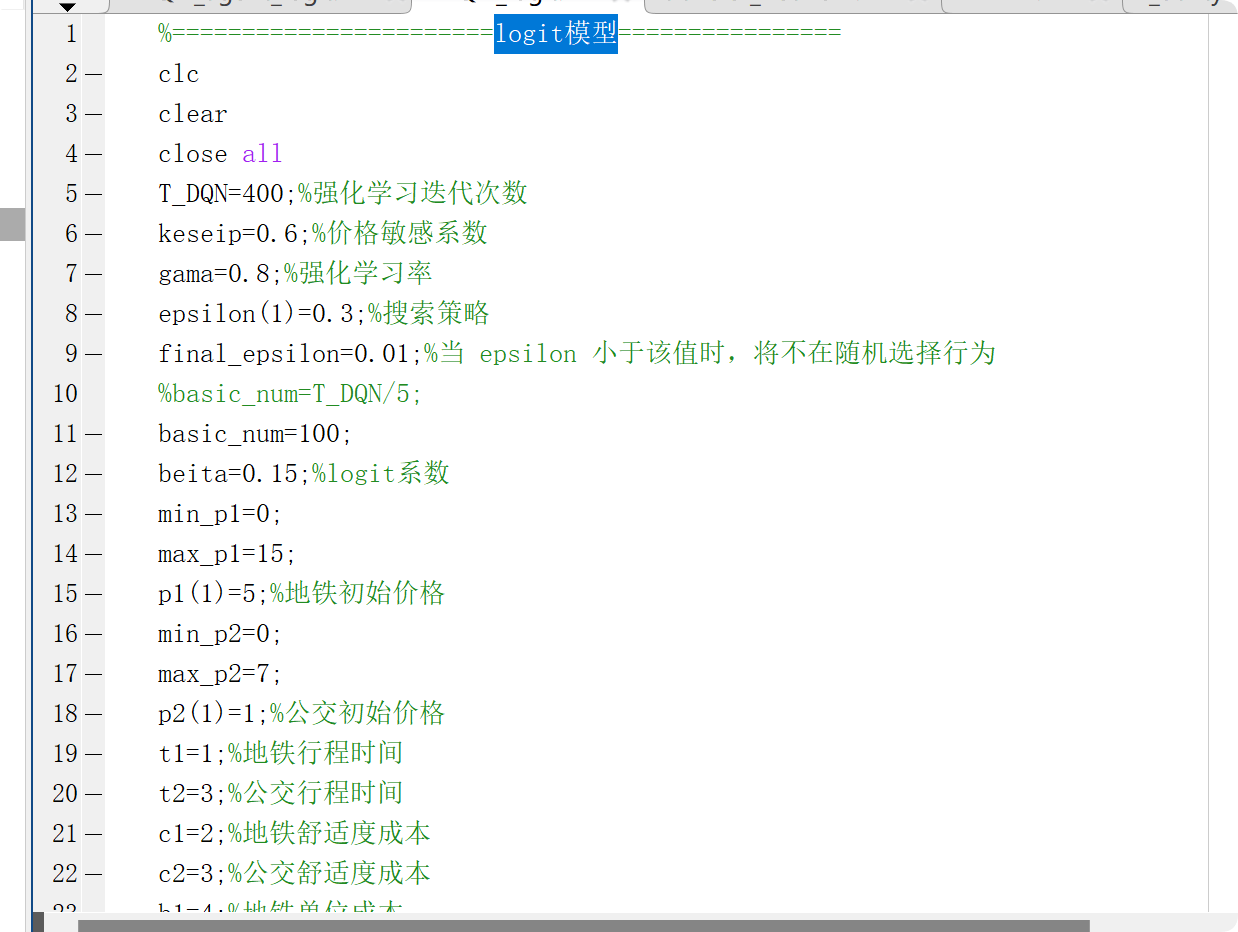

1. Logit模型与DQN的协同机制

Logit模型通过构建效用函数(如出行时间、费用等)预测个体选择概率,为DQN提供行为预测基础。在交通费用优化场景中,Logit模型可量化不同定价策略下用户的出行方式选择概率,例如公共交通与私家车的选择比例。DQN可将这些概率作为状态空间的一部分,动态调整定价策略以最大化长期收益。例如:

- 状态表示:将Logit模型输出的各交通方式选择概率(如公交选择概率PbusPbus、私家车概率PcarPcar)与环境变量(如实时交通流量、天气)结合,形成多维状态向量。

- 奖励函数设计:以Logit预测的出行转移率(如从私家车转向公交的用户比例)作为奖励指标,激励DQN智能体优化定价策略以提升系统效率。

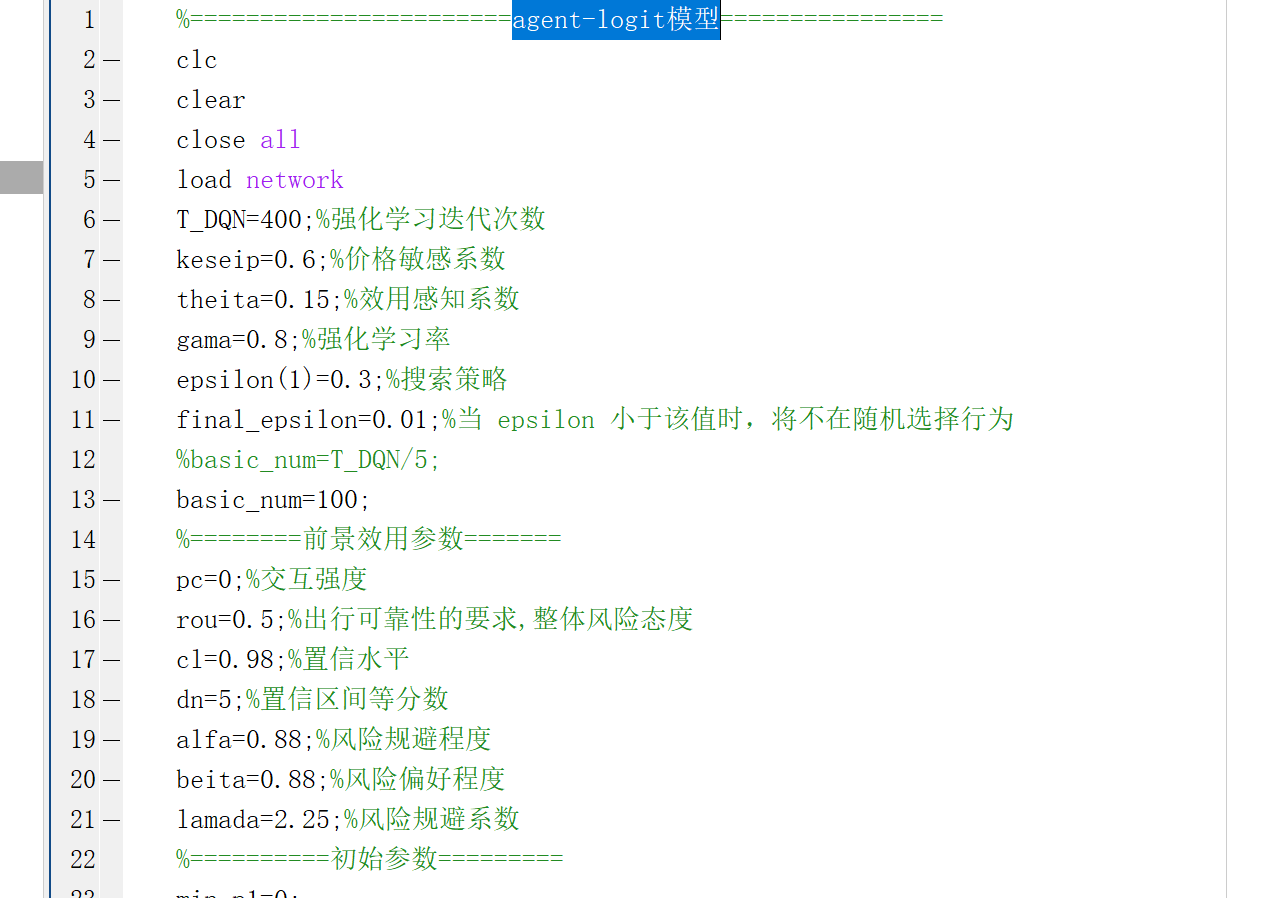

2. Agent-Logit模型的异质性建模

传统Logit模型假设同质性,而Agent-Logit模型(如随机参数Logit、潜在类别模型)通过引入个体异质性参数,更精准刻画多样化用户行为。在生成Agent网络中,每个Agent的决策可基于个性化Logit效用函数:

- 参数随机化:为每个Agent分配随机系数(如对价格的敏感度βcostβcost服从正态分布),模拟不同用户群体的选择偏好。

- 动态效用更新:在DQN训练过程中,根据实时交互数据(如用户反馈)调整Agent的效用参数,实现模型在线学习。

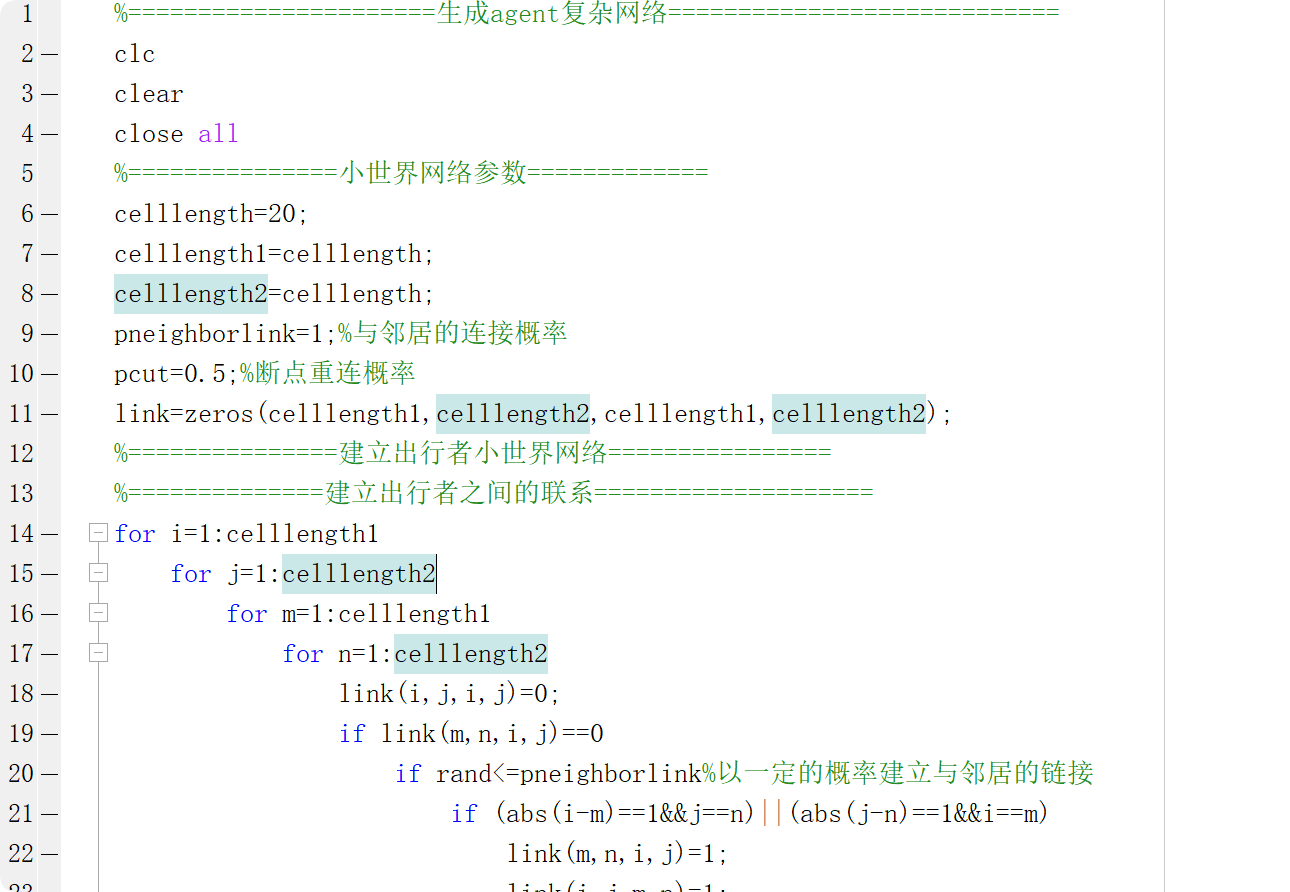

3. 生成Agent复杂网络的环境构建

生成Agent网络通过多Agent系统(MAS)模拟交通参与者的交互,其核心包括:

- Agent类型:车辆Agent(感知环境、决策路径)、信号控制Agent(优化信号配时)、用户Agent(基于Logit模型选择出行方式)。

- 网络拓扑:构建分层结构,例如路口Agent管理局部交通流,区域协调Agent优化全局路网。

- 交互协议:通过通信机制(如V2X)实现Agent间状态共享,例如用户Agent的出行意图可提前传递给信号控制Agent,辅助动态调整绿灯时长。

4. DQN与多Agent系统的集成策略

将DQN嵌入Agent网络,形成“集中训练-分散执行”架构:

- 集中训练:DQN作为中央控制器,接收全网络状态(如各路口流量、用户选择分布),输出全局策略(如区域定价方案、信号配时模板)。

- 分散执行:各Agent根据局部观测执行动作(如车辆Agent选择路径、用户Agent响应票价),同时通过经验回放池向DQN反馈交互数据。

- 混合奖励机制:结合全局目标(如碳排放减少)与局部目标(如单个用户等待时间最短),通过加权奖励平衡系统与个体利益。

5. 应用场景与案例验证

- 动态定价优化:以为例,将Logit模型预测的用户弹性作为DQN输入,通过调整公交票价引导出行结构,实验显示优化后公交分担率提升12%。

- 信号控制协同:中,多Agent DQN通过嵌套Logit模型预测路口流量分布,动态调整信号相位,使平均等待时间减少23%。

- 路径规划与充电调度:在电动汽车场景中,Agent-Logit模型模拟司机充电偏好,DQN优化充电站布局与电价,降低拒载率38%。

6. 技术挑战与解决方案

- 计算复杂度:采用分布式DQN架构,将大规模Agent网络划分为子群并行训练。

- 模型一致性:定期同步全局Logit参数与局部Agent参数,避免策略漂移。

- 数据稀疏性:结合生成对抗网络(GAN)合成罕见交通场景数据,增强DQN泛化能力。

7. 未来研究方向

- 多模态Logit-DQN融合:整合离散选择模型与深度强化学习的端到端训练框架,实现效用函数参数的自适应学习。

- 跨模态Agent协作:探索语言模型(LLM)与Logit-DQN的交互,通过自然语言指令调整策略,提升系统可解释性。

- 边缘计算部署:在车端或路侧单元部署轻量化DQN模型,支持实时决策与隐私保护。

结论

通过Logit模型的行为预测、Agent-Logit的异质性建模、生成Agent网络的复杂交互模拟,结合DQN的全局优化能力,可显著提升交通系统的预测精度与决策效率。典型案例表明,该方法在动态定价、信号控制等领域具有显著优势,未来需进一步解决计算效率与模型泛化问题,推动智能交通系统的实际落地。

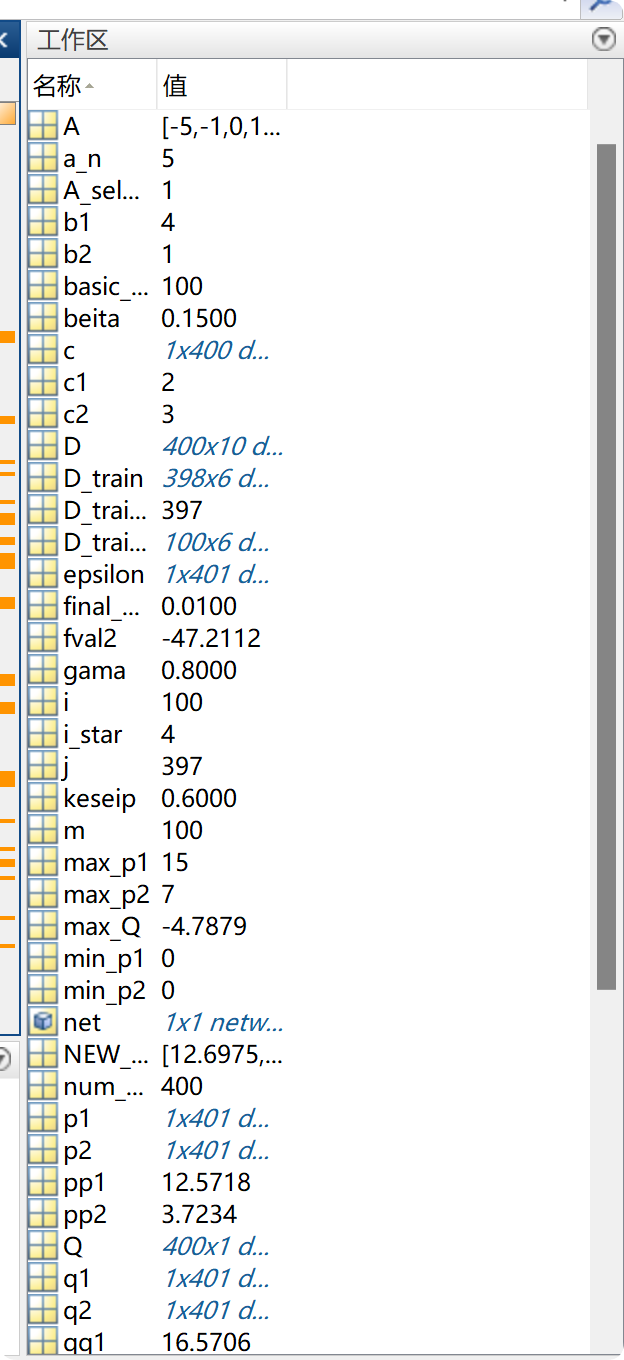

📚2 运行结果

仅包含运行数据,没可视化展示。

部分代码:

🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]吴卫,阴佳腾,陈照森,et al.基于深度强化学习 DDDQN 的高速 列车智能调度调整方法[J].Journal of Railway Science & Engineering, 2024, 21(4).

[2]赵静.基于深度强化学习的多路径调度模型[J].甘肃科技纵横, 2024, 53(4):58-65.

[3]李国文,张玉超,丁垠午,等.基于注意力多智能体强化学习的多目标终生路径规划[C]//2024中国自动化大会论文集.2024.

🌈4 Matlab代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)