voc2007目标检测数据集制作

labelImg是用python和qt编写的工具1.工具下载:label工具的github下载地址:https://github.com/tzutalin/labelImg/tree/bf8cc1d5756184b9af8e412929efdaa6ae0ba4f1在此感谢大神的贡献,工具真的很好用,一目了然。2. 如果电脑还没有安装anaconda,则先安装anaconda软件。...

1. labelImg安装

1.工具下载:label工具的github下载地址:https://github.com/tzutalin/labelImg/tree/bf8cc1d5756184b9af8e412929efdaa6ae0ba4f1

在此感谢大神的贡献,工具真的很好用,一目了然。

2. 如果电脑还没有安装anaconda,则先安装anaconda软件。然后进入到下载好的labelImg目录下,输入cmd,进入控制台。

3.安装qt,我安装的是QT5,命令行输入

conda install pyqt=5linux下qt5的安装:同样进入到labelImg目录下,输入以下命令:

sudo apt-get install pyqt5-dev-tools等待安装完成后在输入:“make qt5py3” 若出现“pyrcc5 -o libs/resources.py resources.qrc”则表示安装成功。

4.等待安装完后,在命令行输入

pyrcc5 -o libs/resources.py resources.qrc5.再输入

python labelImg.py即打开标注工具。

标注工具使用就不作说明了,一目了然,设置图片路径和标注好的xml文件路径即可,图片标注好后会自动在所设置的目录下生成对应的xml文件,且名称与图片相同。图像路径和标注保存的xml路径中最好不要有中文名,否则后面生成训练要用的txt文件时可能会不识别。

2. VOC2007格式数据制作

1. 在工程目录中新建文件夹命名为“VOC2007”;

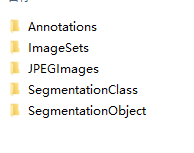

2.网上下载一个voc2007格式的数据集,将该数据集下的Annotations以及JPEGImages清空,将自己标注好的图片放入JPEGImages,生成的xml文件放入Annotations,将SegmentationClass和SegmentationObject文件夹也清空,ImageSets下面三个子文件夹的内容也清空,但保留三个文件夹,名字不要改动。

(提供voc2007数据格式的csdn资源https://download.csdn.net/download/feng1479580895/10320841)

使用以下代码生成Main中的四个文件

import os

import random

trainval_percent = 0.7

train_percent = 0.5

xmlfilepath = 'Annotations'

txtsavepath = 'ImageSets\Main'

total_xml = os.listdir(xmlfilepath)

num=len(total_xml)

list=range(num)

tv=int(num*trainval_percent)

tr=int(tv*train_percent)

trainval= random.sample(list,tv)

train=random.sample(trainval,tr)

ftrainval = open('ImageSets/Main/trainval.txt', 'w')

ftest = open('ImageSets/Main/test.txt', 'w')

ftrain = open('ImageSets/Main/train.txt', 'w')

fval = open('ImageSets/Main/val.txt', 'w')

for i in list:

name=total_xml[i][:-4]+'\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftrain.write(name)

else:

fval.write(name)

else:

ftest.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest .close()

这一步的详细步骤也可以参考这篇博客:https://blog.csdn.net/jx232515/article/details/78680724

这样,VOC2007的数据格式制作完了;

2.1. 位置文本信息生成脚本

直接上脚本代码:

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

classes = ["car","dog", "person"]#类型自己设置,不同类型用逗号隔开

def convert(size, box):

dw = 1./(size[0])

dh = 1./(size[1])

x = (box[0] + box[1])/2.0 - 1

y = (box[2] + box[3])/2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x*dw

w = w*dw

y = y*dh

h = h*dh

return (x,y,w,h)

def convert_annotation(image_id):

in_file = open('labelimg保存的xml路径/%s.xml'%(image_id), "r", encoding="utf-8")#读取标注数据,并支持中文字符

out_file = open('txt文本输出路径/%s.txt'%(image_id), 'w')#输出的标注训练数据文本文件

tree=ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult)==1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

bb = convert((w,h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()#获取当前执行文件夹的路径

if not os.path.exists('输出txt文本文件夹路径'):#判断是否存在输出文件夹

os.makedirs('输出txt文本文件夹路径')#不存在则创建输出文件夹

image_ids = open('voc数据路径\ImageSets\Main/train.txt').read().strip().split()#分离文本中的imageID

list_file = open('2007_train.txt','w')

for image_id in image_ids:

list_file.write('voc数据路径\images/%s.jpg\n'%(image_id))#将路径写入到文本文件中

convert_annotation(image_id)

list_file.close()

附:将voc2007数据格式转换为tensorflow数据格式

源码github地址:https://github.com/balancap/SSD-Tensorflow

1. 在工程的根目录下创建名称为“tfrecords_”的文件夹,带下划线的;

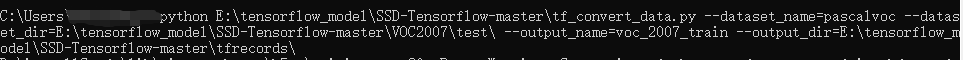

2. 打开命令窗口,根据balancap作者给出的tf_convert_data.py文件的使用方式,输入如下命令:

第一个参数是python,第二个参数是tf_convert_data.py文件的路径,第三个参数是“--dataset_name=pascalvoc_2007”,第四个是你制作好的VOC2007格式的数据的路径,第五个是“--output_name=voc_2007_train”,第六个数输出的tfrecord格式的输出目录。

(注:目录设置时,最后不要忘记加“\”)

若是成功运行,则会出现如下界面

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)