什么是GPU?—— 从本质到应用的通俗解析

GPU 的核心是 “并行计算”,从最初的图形渲染工具,进化为 AI 时代的核心算力支撑 —— 对于计算机科学领域的科研 / 工作而言,GPU 是处理海量数据、训练复杂模型、加速科研进程的 “必备工具”。理解 GPU 的并行特性、选型逻辑和软件适配,能帮助更高效地开展研究(如大模型训练、科学计算、AI 应用开发)。

GPU(Graphics Processing Unit,图形处理器)是计算机核心硬件之一,最初设计用于处理图形渲染(如游戏、视频编辑),但因其并行计算能力极强,如今已成为人工智能、科学计算、深度学习等领域的核心算力支撑(这也是计算机科学领域科研 / 求职中高频接触的硬件)。

一、GPU 的核心本质:“并行计算专家”

要理解 GPU,最关键的是对比它与 CPU(中央处理器)的设计差异 —— 两者的核心区别在于 “任务处理模式”,用通俗类比就能快速明白:

| 对比维度 | CPU(中央处理器) | GPU(图形处理器) |

|---|---|---|

| 核心定位 | “全能办公经理” | “流水线工人团队” |

| 核心数量 | 少(常见 4-32 核) | 极多(数千甚至数万核) |

| 处理模式 | 串行计算(逐一处理复杂任务) | 并行计算(同时处理海量简单任务) |

| 擅长场景 | 系统调度、复杂逻辑判断(如办公软件、编程编译) | 重复数据处理、矩阵运算(如图形渲染、AI 训练) |

| 比喻场景 | 一个资深专家解决一道复杂数学题 | 一万个小学生同时计算 1+1(总量远超专家) |

简单说:CPU 像 “全能手”,擅长处理需要逻辑判断、步骤依赖的复杂任务;GPU 像 “千手观音”,不擅长复杂逻辑,但能同时开工处理海量重复、独立的简单任务 —— 这正是 AI、深度学习、科学计算的核心需求(比如训练神经网络时,需要对海量数据做相同的矩阵乘法)。

二、GPU 的发展历程:从 “图形专用” 到 “通用算力”

-

早期(1990s-2000s):图形渲染专用最初 GPU 的唯一作用是处理图形数据:比如将 3D 模型转换为屏幕上的 2D 图像、计算光影效果、纹理贴图(游戏画面、电影特效的核心)。此时的 GPU 功能单一,仅支持图形相关指令。

-

中期(2010s 后):通用计算崛起随着 CUDA(NVIDIA 推出的通用并行计算架构)、OpenCL(跨平台并行计算标准)的出现,GPU 开始支持 “非图形任务”—— 开发者可以通过这些框架,让 GPU 处理任意需要并行计算的任务(如科学模拟、密码破解、AI 训练)。关键转折点:深度学习的爆发。神经网络训练需要对海量数据做重复运算,GPU 的并行能力比 CPU 快数百倍,成为 AI 研究的 “必备工具”(比如训练一个大型语言模型,用 CPU 可能需要几年,用 GPU 仅需几周)。

-

现在:算力核心,跨领域渗透如今 GPU 已成为计算机科学、人工智能、量子计算、生物医药、气象预测等领域的核心算力支撑,甚至被称为 “AI 时代的 CPU”—— 没有强大的 GPU,就没有当前的大模型、自动驾驶、基因测序等技术突破。

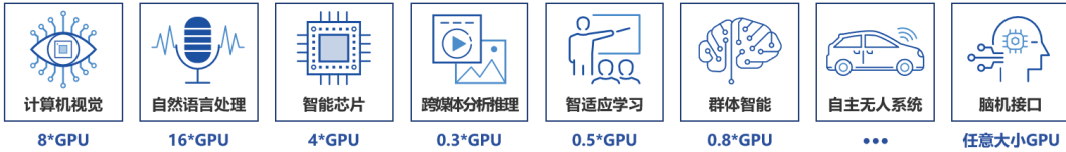

三、GPU 的核心应用场景(结合科研 / 工作实际)

-

深度学习与 AI 研究

- 模型训练:用 GPU 并行处理海量训练数据(如 ImageNet 图像分类、大语言模型预训练),主流框架(TensorFlow、PyTorch)均深度优化 GPU 支持。

- 模型推理:部署 AI 模型时(如实时图像识别、语音翻译),用 GPU 加速推理速度(比 CPU 快 10-100 倍)。

-

科学计算与数值模拟

- 如流体力学模拟、量子力学计算、分子动力学(生物医药领域的蛋白质结构预测)、气象数据处理 —— 这些任务需要对海量数据做重复运算,GPU 能大幅缩短计算时间(比如原本 CPU 需要 1 个月的模拟,GPU 可能 1 天完成)。

-

图形与多媒体处理

- 视频编辑(如 4K/8K 视频渲染、特效制作)、3D 建模(如科研中的场景仿真)、虚拟现实(VR/AR)—— 这些是 GPU 的传统强项,科研中可能用于可视化实验结果(如 3D 展示神经网络结构、模拟数据的空间分布)。

-

高性能计算(HPC)超级计算机(如鹏城实验室的 “鹏城云脑”)的核心算力由 GPU 集群构成 —— 通过数千块 GPU 协同工作,处理国家重大科研项目(如人工智能、气候预测、航空航天仿真)。

四、主流 GPU 厂商与核心产品(科研 / 工作高频接触)

-

NVIDIA(英伟达)

- 优势:CUDA 生态垄断(深度学习框架、科研软件优先支持)、性能领先、算力密度高。

- 核心产品:

- 数据中心级:A100、H100(科研 / 大模型训练首选,算力极强,价格昂贵,单卡数十万元);

- 消费级(科研入门 / 个人使用):RTX 4090、RTX 3090(性价比高,支持深度学习加速,单卡 1-3 万元)。

-

AMD(超微半导体)

- 优势:价格更低、支持 OpenCL 生态,部分科研软件(如流体力学模拟)优化较好。

- 核心产品:MI250(数据中心级)、RX 7900 XTX(消费级)—— 生态不如 NVIDIA 完善,但性价比高。

-

华为(Ascend)

- 优势:自主研发,适配国产深度学习框架(MindSpore),适合国内科研机构 / 企业(规避制裁风险)。

- 核心产品:Ascend 910(对标 NVIDIA A100,大模型训练)、Ascend 310(推理部署)。

-

Intel(英特尔)

- 产品:Data Center Max 系列(数据中心级)、Arc 系列(消费级)—— 生态尚不成熟,科研领域应用较少。

五、科研中使用 GPU 的关键注意点

-

算力选型:

- 模型训练(如大模型、复杂神经网络):优先选数据中心级 GPU(A100、H100、Ascend 910),显存大(80GB+)、算力强,支持多卡协同;

- 模型推理 / 小型实验:消费级 GPU(RTX 4090、RX 7900 XTX)足够,显存 12GB + 即可满足大部分中小型模型需求。

-

软件适配:

- 深度学习框架:TensorFlow、PyTorch 默认支持 NVIDIA GPU(需安装 CUDA Toolkit),华为 GPU 需安装昇腾 AI 框架(MindSpore、TensorFlow/Ascend 版);

- 科研软件:MATLAB、ANSYS、GROMACS(分子动力学)等均支持 GPU 加速,需确认软件的 GPU 适配版本(如是否支持 CUDA/OpenCL)。

六.GPU 核心性能指标解释

- 计算核心相关

- CUDA 核心:NVIDIA GPU 的基础计算单元,负责浮点运算、整数运算等通用任务,同架构下数量越多,并行处理通用任务的能力越强。AMD 对应核心为流处理器,作用类似。

- Tensor 核心:NVIDIA 专属专用计算单元,专为深度学习的矩阵运算设计,通过混合精度计算大幅提升 AI 训练和推理效率,是其在 AI 领域的核心优势之一。AMD 则通过 AI Tensor Engine(AITER)实现类似功能。

- 算力指标

- TFLOPS:每秒浮点运算次数,衡量计算性能的核心指标,1TFLOPS=10¹² 次 / 秒,需结合精度区分,如 FP8(适合大模型训练推理)、FP16(兼顾速度与精度)、FP32(通用科学计算)、FP64(高精度科学计算如量子模拟)。

- 显存相关

- 显存容量:决定 GPU 可加载的模型参数、数据量大小,大模型训练推理需大容量显存避免内存溢出,主流数据中心级 GPU 显存已达 80GB 以上。

- 显存带宽:单位 GB/s,衡量显存读写速度,直接影响数据传输效率,带宽越高,处理大批量数据时越流畅,计算公式为显存带宽 = 位宽 × 显存频率 ÷8。

- 显存类型:主流为 GDDR7(消费级)、HBM3(数据中心级),HBM3 带宽远高于 GDDR7,适配高负载场景。

- 互联与功耗

- 互联技术:如 NVIDIA 的 NVLink,用于 GPU 间高速通信,提升分布式集群的协同效率;AMD 则通过 Infinity Fabric 实现类似功能。

- 功耗(TDP):反映 GPU 能耗,高功耗通常对应高性能,但需匹配散热方案,否则会因降频影响性能稳定性。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)