扩散模型有什么算力要求不高,1张显卡即可胜任的研究领域呢?

点击上方“3D视觉工坊”,选择“星标”干货第一时间送达内容来自知乎,「3D视觉工坊」整理,如有侵权请联系删除https://www.zhihu.com/question/609134632扩散模型有什么算力要求不高,1张显卡即可胜任的研究领域呢?作者 无所知从训练角度看,文生图类的扩散模型,有几个方向。一个是从头训练一个新的结构或者新的模型,例如Google的Imagen系列,只有一个非官方实现.

点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

内容来自知乎,「3D视觉工坊」整理,如有侵权请联系删除 https://www.zhihu.com/question/609134632

扩散模型有什么算力要求不高,1张显卡即可胜任的研究领域呢?

作者 无所知

从训练角度看,文生图类的扩散模型,有几个方向。

一个是从头训练一个新的结构或者新的模型,例如Google的Imagen系列,只有一个非官方实现的框架,你想在它上面做实验,那就需要自己从头训练,这就需要天量的算力了(基本是256*A100这个级别的),单卡就别想了。

另一个是对现有模型进行微调,微调的方式有很多,比如1)传统的finetune模式;2)基于lora的微调;这里面传统的finetune是最费算力的,不比从头训少消耗多少算力;lora算是最省算力的,目前有8G单卡就能跑的方案。

另外看图像编辑,图像编辑有很多,我举几个例子,1)基于原始sd的inpainting方案/基于新sd的inpainting的方案,具体的区别可以看看我之前的文章;2)像controlnet或者t2iadapter的额外链接,对生成进行控制;3)prompt-to-prompt,文本修改引导图像固定区域修改;4)paint-by-example,用图像而非文本引导生成......

这里面,非要说单卡能跑的就是“基于原始sd的inpainting方案”,因为这不涉及训练,只涉及如何组合的问题;另外几个都需要大量的实验和训练,单卡比较难。

回到这个问题上,单卡情况下,我觉得可以考虑试着研究下lora,比如现在的lora位置是否是最优位置,能否有更优化的调整方案?或者看看lora在文生3D领域能否有什么应用?

作者 书痴梦笔

在只有一张GPU卡的情况下,你可以研究和发表的方向有很多,以下是一些建议:

1. 性能优化:针对你的扩散模型,你可以尝试优化算法和代码以提高模型的训练速度和推理速度。这可能涉及到并行计算、内存管理、计算图优化等方面。

2. 模型压缩:将扩散模型进行压缩,以减少模型的存储需求和计算资源需求。你可以尝试使用剪枝、量化、低秩分解等技术来减小模型的大小和计算复杂度。

3. 模型并行化:通过将模型的层或子模块分配到不同的GPU上,实现模型的并行计算,从而加快训练速度或推理速度。这可以通过数据并行或模型并行来实现。

4. 超参数调优:尝试使用不同的超参数设置来训练扩散模型,以找到最佳的参数配置。你可以探索学习率、正则化参数、批量大小等超参数的最佳组合,以优化模型性能。

5. 模型扩展:基于扩散模型的基本思想,探索模型的扩展和改进。你可以尝试设计新的模型结构、引入注意力机制、改进模型的层次结构等,以提升模型的性能。

6. 应用领域:将扩散模型应用到特定领域或任务中。你可以选择一个特定的应用领域,如图像处理、自然语言处理等,然后尝试将扩散模型用于该领域的相关任务,并比较其性能表现。

当涉及到特定研究领域和扩散模型的方向时,以下是一些相关的参考文献,供你作为起点进行进一步研究:

1. Abadi, M., Agarwal, A., Barham, P., Brevdo, E., Chen, Z., Citro, C., ... & Ghemawat, S. (2016). TensorFlow: Large-scale machine learning on heterogeneous systems. [arXiv preprint arXiv:1603.04467](TensorFlow: Large-Scale Machine Learning on Heterogeneous Distributed Systems).

2. Han, S., Mao, H., & Dally, W. J. (2016). Deep compression: Compressing deep neural networks with pruning, trained quantization and huffman coding. In International Conference on Learning Representations (ICLR).

3. Keskar, N. S., Mudigere, D., Nocedal, J., Smelyanskiy, M., & Tang, P. T. P. (2017). On large-batch training for deep learning: Generalization gap and sharp minima. In International Conference on Learning Representations (ICLR).

4. Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). Imagenet classification with deep convolutional neural networks. In Advances in Neural Information Processing Systems (NIPS).

5. Lecun, Y., Bottou, L., Bengio, Y., & Haffner, P. (1998). Gradient-based learning applied to document recognition. Proceedings of the IEEE, 86(11), 2278-2324.

6. Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., ... & Polosukhin, I. (2017). Attention is all you need. In Advances in Neural Information Processing Systems (NIPS).

这些参考文献覆盖了深度学习、模型压缩、模型优化和注意力机制等领域的一些经典工作和重要论文。你可以根据自己的研究方向和兴趣,深入阅读这些论文,并根据相关引用和参考文献进一步拓展你的文献调研。记得始终关注最新的研究进展,以保持对领域最新动态的了解。

当然如果只有单卡的话, 我个人还是比较倾向建议去做模型压缩方面的研究工作,毕竟大模型的小型化单卡个性化部署是未来的发展方向,以下是一些与模型压缩相关的研究文献,这些文献涵盖了不同的模型压缩方法和技术:

1. Han, S., Mao, H., & Dally, W. J. (2016). Deep compression: Compressing deep neural networks with pruning, trained quantization and huffman coding. In International Conference on Learning Representations (ICLR).

2. Courbariaux, M., Hubara, I., Soudry, D., El-Yaniv, R., & Bengio, Y. (2016). Binarized neural networks: Training deep neural networks with weights and activations constrained to +1 or -1. In Advances in Neural Information Processing Systems (NIPS).

3. Wu, S., Leng, C., Wang, Y., Hu, Q., & Cheng, J. (2016). Quantized convolutional neural networks for mobile devices. In Computer Vision and Pattern Recognition (CVPR).

4. Zhu, C., Han, S., Mao, H., & Dally, W. J. (2017). Trained ternary quantization. In International Conference on Learning Representations (ICLR).

5. Rastegari, M., Ordonez, V., Redmon, J., & Farhadi, A. (2016). XNOR-Net: ImageNet classification using binary convolutional neural networks. In European Conference on Computer Vision (ECCV).

6. Louizos, C., Ullrich, K., & Welling, M. (2018). Bayesian compression for deep learning. In International Conference on Learning Representations (ICLR)

7. Molchanov, P., Tyree, S., Karras, T., Aila, T., & Kautz, J. (2017). Pruning convolutional neural networks for resource efficient inference. In International Conference on Learning Representations (ICLR).

8. Li, H., Kadav, A., Durdanovic, I., Samet, H., & Graf, H. P. (2016). Pruning filters for efficient convnets. In International Conference on Learning Representations (ICLR).

这些文献代表了模型压缩领域的一些重要工作,涉及到剪枝(pruning)、量化(quantization)、二值网络(binary networks)、低秩分解(low-rank decomposition)和贝叶斯压缩(Bayesian compression)等不同的方法和技术。阅读这些文献可以帮助你了解模型压缩的最新研究进展和方法,以及它们在深度学习领域的应用。

以上只是一些可能的研究方向,你可以根据自己的兴趣和背景选择适合的方向进行研究。同时,还建议查阅相关领域的最新文献,了解当前的研究热点和前沿工作,以便找到一个有足够创新性和学术价值的研究方向。

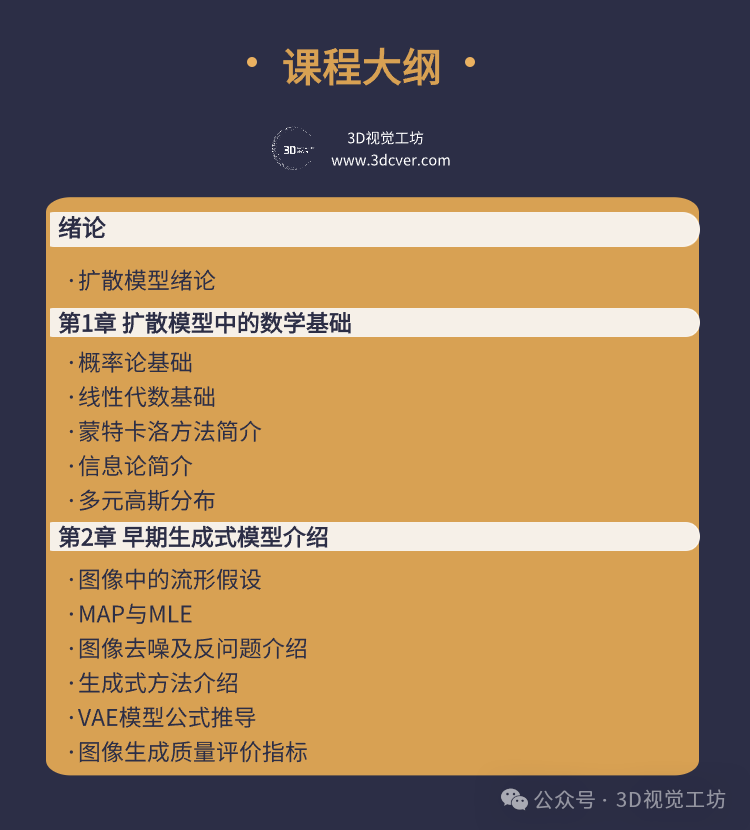

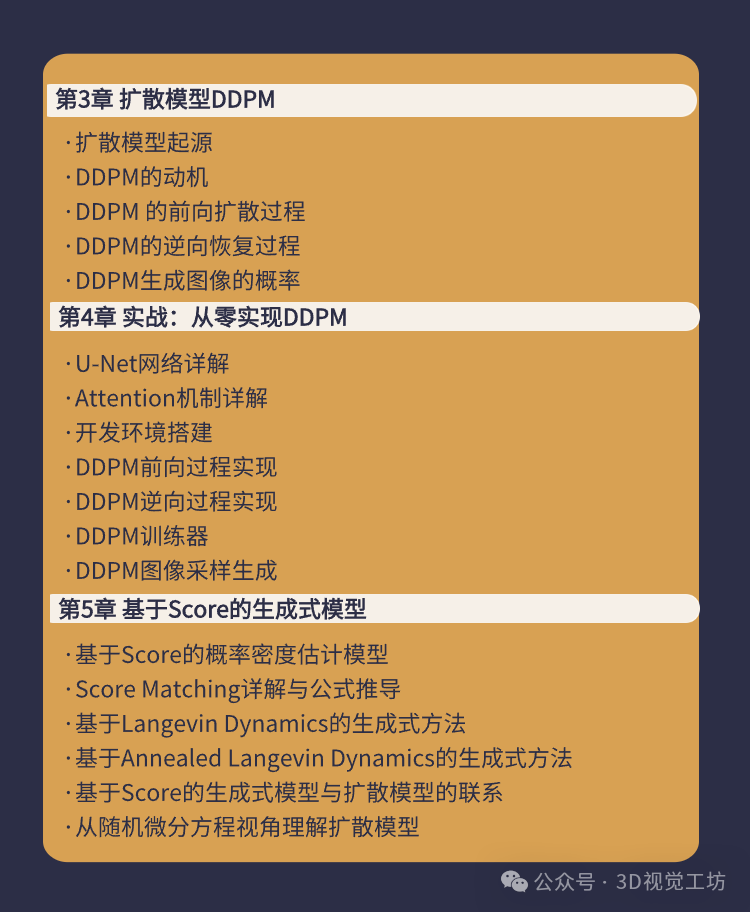

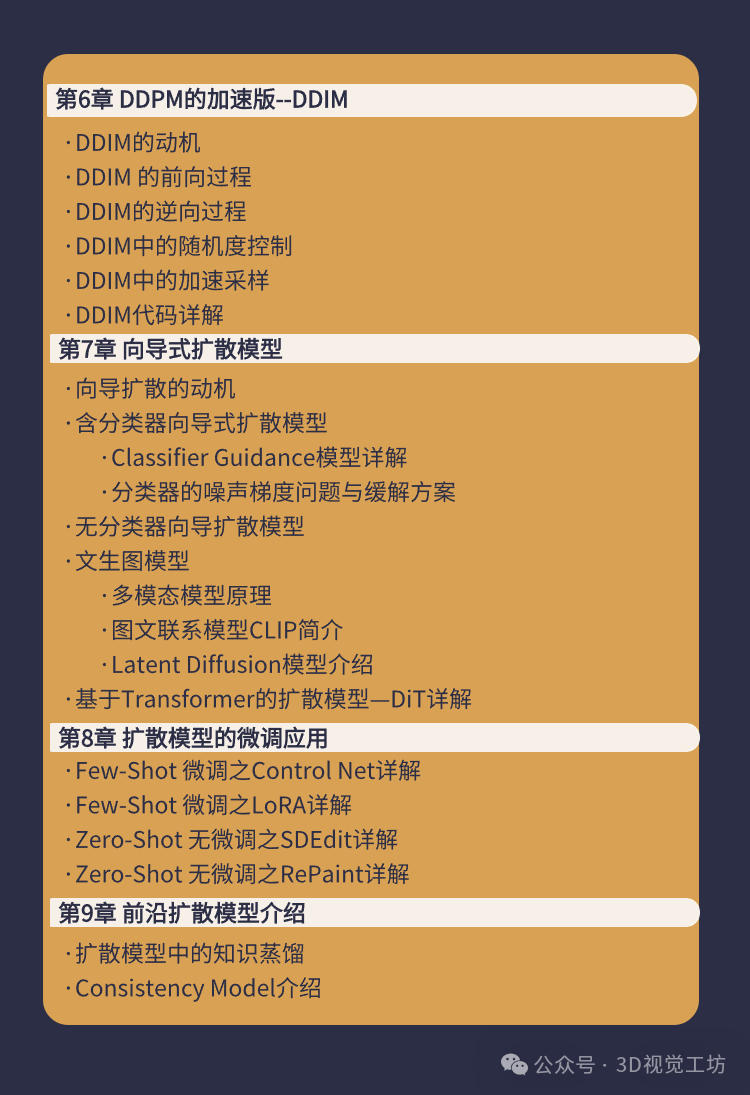

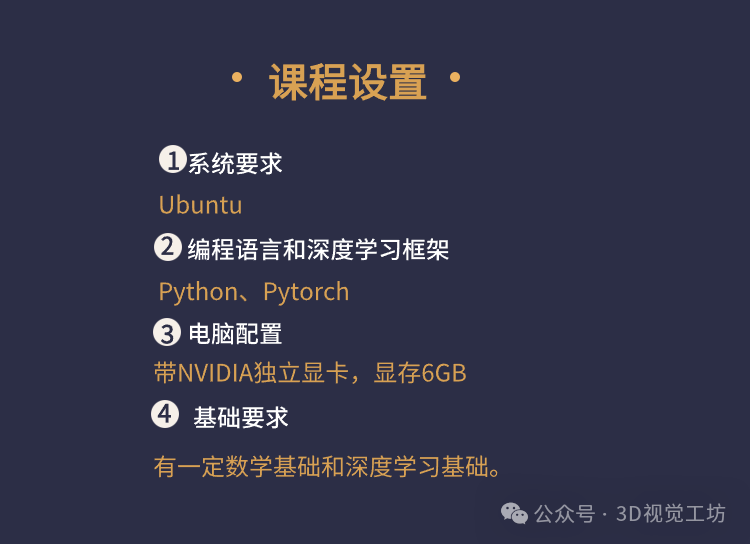

这里给大家推荐一门我们最新的课程《扩散模型入门教程:数学原理、方法与应用》:

课程亮点

-

从零开始,无需基础:目前全网缺乏系统性资料、小白入门无从下手。我们知道学习新技术可能让小白感到有压力。因此,这门课程特别设计了循序渐进的学习路径,从数学基础回顾、传统图像生成方法介绍、到扩散模型的详细讲解和代码实现,引导小白入门扩散模型。

-

理论与实践结合:不仅为你介绍扩散模型的核心原理,还将通过实际操作手把手教你如何使用这些模型生成内容。你将学会如何使用工具如Python、Pytorch等流行编程语言和库,搭建并训练自己的扩散模型。

-

小而精的项目实战:学习扩散模型的最佳方式是动手实践。在课程中,你将从零搭建一个扩散模型,实现图像的生成,全面了解该模型的基本原理。

你将收获什么?

-

深入理解扩散模型的原理:课程将深入浅出地讲解扩散过程、反扩散过程等核心概念,帮助你从根本上特别是数学角度理解这项技术。

-

动手构建扩散模型:你将学会如何从头开始构建一个扩散模型,掌握模型训练的流程,并学会举一反三, 根据业务需要构建扩散模型。

-

了解扩散模型多场景的应用能力:扩散模型不仅用于图像生成,它还能广泛应用于文本生成图像、视频生成、数据增强等领域。我们会带你探索这些不同的应用方向,帮助你找到适合自己的兴趣点。

适合谁来学习?

-

AI初学者:如果你是人工智能的初学者,希望在生成模型领域中快速入门,那么这门课程非常适合你。我们将从基本概念开始,逐步深入,让你轻松掌握核心技术。

-

开发者和程序员:如果你已经有编程基础,并想涉足AI领域,扩散模型是一个理想的切入点。课程中的实践环节将帮助你快速上手,并将理论知识应用于实际项目中。

-

AI爱好者和创作者:无论你是对AI生成艺术感兴趣的创作者,还是想了解更多AI技术的爱好者,这门课将为你提供一个全新的创造力工具,帮助你搭建自己的生成模型实现更多的艺术创意。

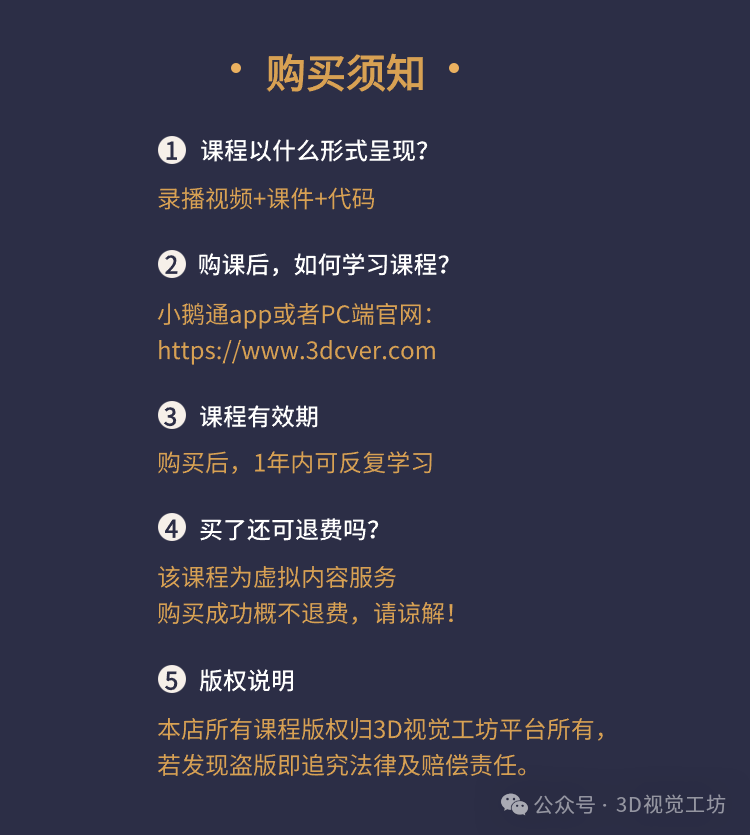

课程答疑

本课程答疑主要在本课程对应的鹅圈子中答疑,学员学习过程中,有任何问题,可以随时在鹅圈子中提问。

备注:以上图片和视频部分来自网络,如果侵犯了您的权益,还请联系删除!

更多推荐

已为社区贡献114条内容

已为社区贡献114条内容

所有评论(0)