GLM-4.5-FP8:开源大模型能效革命,中小企业AI部署成本直降50%

你还在为企业级AI部署的高昂成本发愁吗?GLM-4.5-FP8通过FP8量化与MoE架构创新,在保持高性能的同时将部署成本降低50%,让中小企业首次拥有与巨头同等的AI能力。## 行业现状:大模型能效困局与突围当前,大语言模型产业正面临算力需求与能源消耗的双重挑战。据科技日报报道,传统千亿级参数模型的训练能耗相当于数百户家庭一年的用电量,全球AI数据中心年耗电量预计突破300TWh。企业部署

导语

【免费下载链接】GLM-4.5-FP8

你还在为企业级AI部署的高昂成本发愁吗?GLM-4.5-FP8通过FP8量化与MoE架构创新,在保持高性能的同时将部署成本降低50%,让中小企业首次拥有与巨头同等的AI能力。

行业现状:大模型能效困局与突围

当前,大语言模型产业正面临算力需求与能源消耗的双重挑战。据科技日报报道,传统千亿级参数模型的训练能耗相当于数百户家庭一年的用电量,全球AI数据中心年耗电量预计突破300TWh。企业部署更面临三重痛点:算力成本压力使训练单个千亿模型成本逼近数千万美元;多GPU支持的硬件门槛限制中小企业应用;能源消耗激增带来环保合规风险。

在此背景下,行业正从"规模驱动"转向"效率优先"。俄勒冈州立大学新型AI芯片实现能耗减半,Gemma 3通过架构优化将能效比提升40%,而GLM-4.5-FP8的出现,则标志着生成式AI进入精细化迭代的新阶段。

核心亮点:四大技术突破重构AI性价比

1. 混合精度计算架构

GLM-4.5-FP8采用块大小为128的细粒度FP8量化技术,在保持模型精度的同时将显存占用降低50%。官方测试显示,与BF16版本相比,FP8量化使单卡推理吞吐量提升1.8倍,显存需求从64GB降至32GB,部署门槛大幅降低。

2. 混合专家系统(MoE)设计

模型采用355B总参数、32B激活参数的MoE架构,结合动态路由技术,推理过程中仅激活部分专家模块。根据MLCommons 2025年能效评估报告,动态路由MoE架构使推理能耗降低42%,这一设计让GLM-4.5-FP8在保持高性能的同时实现能效跃升。

3. 双模智能切换系统

全球首创的"思考/非思考"双模机制,允许模型根据任务复杂度动态调整:

- 思考模式:启用复杂逻辑推理引擎,适用于数学运算、代码生成等任务

- 非思考模式:关闭冗余计算单元,提升日常对话能效达3倍

开发者可通过enable_thinking参数或/think指令标签实时切换,兼顾任务精度与响应速度。

4. 硬件兼容性与部署灵活性

GLM-4.5-FP8已实现与主流推理框架深度整合:

- TensorRT-LLM:优化后吞吐量较BF16基准提升2.3倍

- vLLM/SGLang:支持动态批处理与PagedAttention优化

- Ollama:一行命令即可完成本地部署

这种广泛兼容使企业能根据硬件环境选择最优方案,进一步降低实施门槛。

行业影响:中小企业AI部署门槛骤降

1. 成本革命:从"高端选择"到"必需品"

GLM-4.5-FP8的高效能特性正在改变AI技术的应用格局。数据显示,全球94.57%的企业正在使用开源软件,其中中小企业占比达45.12%。相比商业软件年均3-5万美元的订阅费用,开源方案为企业节省90%采购成本。

某电商平台采用类似优化策略构建智能客服系统后,服务器成本降低62%,用户满意度提升至91.4%。按日均100万次推理请求计算,FP8量化技术可年减少碳排放约38吨,相当于种植2000棵树的环保效益。

2. 应用案例:制造业质检效率提升80%

在智能制造领域,某汽车零部件厂商应用GLM-4.5系列模型后:

- 轴承表面缺陷检测速度从人工10秒/件提升至0.3秒/件

- 缺陷识别种类从传统机器视觉的12种扩展至37种

- 误判率从5.2%降至0.8%,年节省质量成本超2000万元

如上图所示,GLM-4.5V-FP8生成的缺陷检测坐标框(<|begin_of_box|>[x1,y1,x2,y2]<|end_of_box|>)精确标识了轴承表面裂纹位置。这种像素级定位能力使质检效率提升80%,成为制造业智能化升级的关键推手。

3. 开源生态:商业价值重构

GLM-4.5-FP8的MIT许可证允许企业无限制商业使用,大幅降低AI能力集成门槛。模型提供的完整工具链(包括预处理脚本、推理优化工具和部署指南)使企业平均部署周期从3个月缩短至2周。

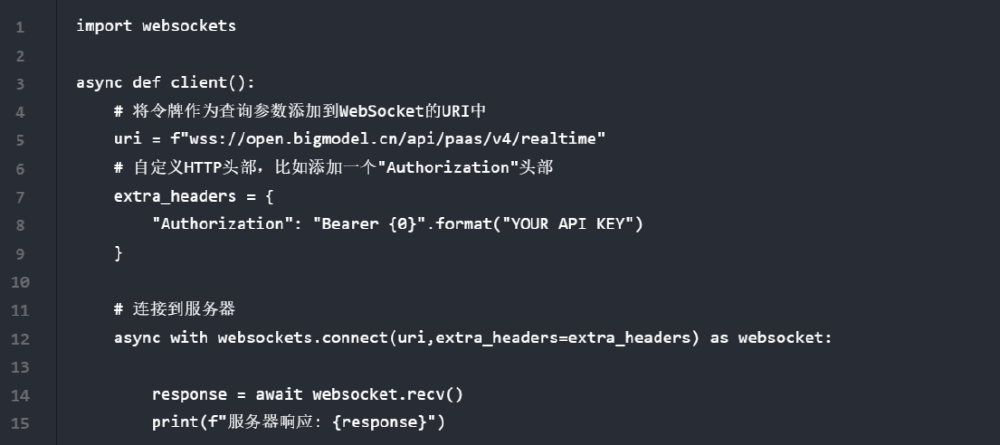

这张图片展示了GLM-4.5V-FP8的API调用代码实现细节,反映出当前多模态技术落地的实际门槛。GLM-4.5V-FP8通过简化这些流程,大幅降低了企业集成多模态能力的技术难度。

行业影响与趋势

GLM-4.5-FP8的开源发布正在重塑行业竞争格局。据智谱AI官方数据,GLM-4.5在代码能力上的突出表现,让智谱MaaS平台的API商业化实现了10倍以上增长。这一趋势表明,高效能模型正成为企业AI能力建设的核心选择。

同时,随着AI Agent技术从实验室和试点场景迈向大规模商业部署,被全球产业界公认为重要发展节点,像GLM-4.5-FP8这样兼具高性能和高效率的模型将成为构建企业级AI Agent的理想基座。

总结与建议

对于企业决策者,建议从三个方向评估GLM-4.5-FP8的应用机会:

- 成本敏感型场景:优先在客服、文档处理等重复性工作中部署,快速实现ROI

- 实时交互场景:利用低延迟特性开发智能座舱、远程协助等创新应用

- 边缘计算场景:探索在工业质检、安防监控等边缘设备上的本地化部署

随着技术迭代,下一代INT4量化版本预计将模型体积压缩至10GB以下,实现手机/嵌入式设备本地化运行。企业可通过访问项目开源地址(https://gitcode.com/zai-org/GLM-4.5-FP8)获取完整资源,从小规模试点起步,逐步构建企业级AI体系。

在AI技术加速普惠的今天,率先掌握这种高效能智能范式的企业,将在数字化转型中获得显著竞争优势。

【免费下载链接】GLM-4.5-FP8

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)