高通跃龙QCS8550平台部署:Qwen2.5-7B大模型与Agent+RAG技术的融合

在人工智能技术快速迭代的当下,硬件性能与模型部署的适配性成为决定 AI 应用落地效率的关键因素。高通跃龙 QCS8550 作为一款高性能计算平台,以其强大的算力与低功耗优势,为前沿 AI 技术的部署提供了优质载体。而 Qwen2.5-7B 大语言模型结合 Agent 智能体与 RAG(检索增强生成)技术,凭借出色的理解与生成能力,正重塑人机交互与信息处理的范式。

前言

在人工智能技术快速迭代的当下,硬件性能与模型部署的适配性成为决定 AI 应用落地效率的关键因素。高通跃龙 QCS8550 作为一款高性能计算平台,以其强大的算力与低功耗优势,为前沿 AI 技术的部署提供了优质载体。而 Qwen2.5-7B 大语言模型结合 Agent 智能体与 RAG(检索增强生成)技术,凭借出色的理解与生成能力,正重塑人机交互与信息处理的范式。本文聚焦高通跃龙 QCS8550 平台部署实践:Qwen2.5-7B 大模型与 Agent+RAG 技术的深度融合方案,将详细拆解在该平台上部署这一先进 AI 组合的全流程,探讨技术难点与优化策略,为相关领域的开发者与研究人员提供可复用的实践经验。

高通跃龙QCS8550芯片参数

https://www.qualcomm.com/products/technology/processors/qcs8550

Qwen2-7B下载

https://hf-mirror.com/aplux/Qwen2.5-7B-Instruct

本次测试采用的硬件设备

https://docs.aidlux.com/guide/hardware/ai-box/AIBoxA8550BM1-user-manual

LLM+RAG构建的高通大赛智能AI助手在线体验地址

一、Qwen2.5-7B是什么?

Qwen2.5-7B 是阿里云发布的大型语言模型,属于 Qwen2.5 系列。以下是关于它的详细介绍:

模型基本信息

参数规模:参数总量为 7.61B,其中非嵌入层参数为 6.53B。

注意力头数:Q 为 28,KV 为 4。

开源协议:以 Apache 2.0 开源协议开源,可完全免费商用。在 Hugging Face 上有基座版本、指令微调版本等多个版本可供下载。

模型特点

训练数据丰富:在多达 18T 个标记的大规模数据集上进行预训练。

指令遵循能力强:如 Qwen2.5-7B-Instruct 版本专门为理解和执行指令设计,能准确解释用户命令,在问答、摘要、翻译等任务中具有更高的准确性和一致性。

长文本处理出色:支持长达 128K tokens 的上下文,能生成最长 8K tokens 的文本。

多语言支持:支持超过 29 种语言,包括中文、英语、法语、西班牙语等常见语言。

对多样提示适应性强:更能适应系统提示的多样性,增强了聊天机器人的角色扮演实现和条件设定。

性能提升显著:在指令跟踪、生成长文本、理解结构化数据(如表格)以及生成结构化输出(尤其是 JSON)方面有显著改进;在知识量、编码和数学能力上也有明显提升,引入专业知识模型后,在编码和数学领域的处理能力大幅提高。

适用场景

文本生成:可用于撰写文章、生成报告、创作故事等。

代码和数学任务:能进行自动编程、解答数学问题等。

数据分析:可以理解表格数据、生成结构化输出等,适用于教育、医疗、金融、客户服务等多个行业。

使用便捷性:模型代码已集成到最新的 Hugging Face transformers库中,用户可方便地使用该框架来部署和训练模型。

此外,Qwen2.5 系列还有 Qwen2.5-Omni-7B 这个全模态大模型,能处理文本、图像、音频和视频等多种数据,并实时生成文本和语音3。但 Qwen2.5-7B 与 Qwen2.5-Omni-7B 不同,Qwen2.5-7B 是单纯的语言模型,主要侧重于自然语言处理任务。

二、AI Agent是什么?

1. AI Agent 的本质定义与核心特征

AI Agent(智能体) 是一种能够感知环境、自主决策并执行动作的人工智能系统。它通过整合大语言模型(LLM)、工具调用能力和规划推理机制,将传统的 “被动响应式” AI 转化为 “主动执行任务” 的智能体。其核心特征包括:

环境感知:通过 API 或插件连接外部数据源(如网络、数据库、文件系统),获取实时信息。

自主决策:基于 LLM 的推理能力分析问题,制定执行策略(如分解任务、选择工具)。

行动执行:调用外部工具(如搜索引擎、计算器、代码解释器)完成复杂任务,并迭代优化结果。

2. AI Agent 的技术架构与工作流程

典型的 AI Agent 系统包含以下关键组件:

1. 规划器(Planner)

解析用户指令,将复杂任务分解为子任务序列(如 “先检索数据→再分析趋势→最后生成报告”)。

2. 工具库(Toolkit)

集成各类功能工具(如 Web 检索、文件操作、API 调用),供 Agent 在执行过程中按需调用。

3. 执行器(Executor)

按规划调用工具,处理中间结果,并根据反馈调整策略(如重试失败的操作)。

4. 记忆模块(Memory)

存储历史对话、中间结果和经验教训,支持多轮对话和长期任务执行。

3. AI Agent 与传统 AI 的关键区别

4. AI Agent 的典型应用场景

▶ 垂直领域专家系统

医疗领域:分析患者病历、检索最新研究成果并辅助医生制定治疗方案。

金融领域:实时监控市场动态,结合历史数据生成投资组合建议。

▶ 自动化工作流机器人

内容创作:根据大纲自动撰写文章、生成配图并发布到自媒体平台。

IT 运维:检测系统异常、调用故障排查工具并执行修复操作。

▶ 复杂问题求解

科研辅助:设计实验方案、分析数据、撰写论文摘要的全流程支持。

多轮对话决策:如旅行规划(根据预算→筛选目的地→预订机票酒店)。

5. AI Agent 的核心技术挑战

工具调用的鲁棒性:如何确保 Agent 正确理解工具使用场景,避免错误调用(如用计算器处理文本分析)。

长期规划能力:在多步骤任务中保持目标一致性,避免 “偏离主线”。

可解释性与可控性:理解 Agent 决策逻辑,防止执行有害或不符合预期的操作。

资源效率:优化推理成本,避免过度调用外部工具导致性能下降。

6. 代表性 AI Agent 框架与工具

LangChain:提供任务规划、工具链管理、记忆存储等基础组件,支持快速构建自定义 Agent。

AutoGPT:早期开源 Agent 框架,展示了 Agent 自主执行长期任务的潜力(如自动创建和运营博客)。

GPT-4 Turbo with Functions:OpenAI 推出的模型,原生支持函数调用,降低了 Agent 开发门槛。

Dify:专注于任务优先级排序和执行的轻量级框架,适合资源受限场景。

AI Agent 正推动人工智能从 “工具” 向 “助手”“伙伴” 的角色演进,尤其在需要跨领域知识整合、多步骤决策的场景中,其价值将愈发显著。随着技术成熟度提升,未来可能出现 “通用型企业智能体”,一站式处理公司运营中的各类复杂任务。

三、使用步骤

1. 安装RAG引擎与Agent框架:dify

请参考文章高通跃龙 QCS8550 与Dify协同:边缘端本地知识库构建与 RAG 优化实践-CSDN博客

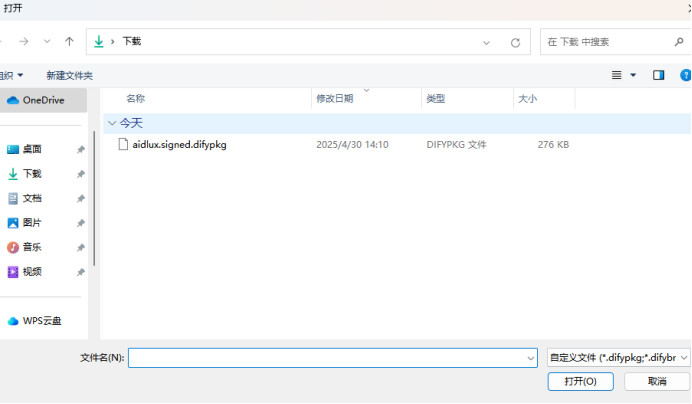

2. 安装aidllm及下载模型

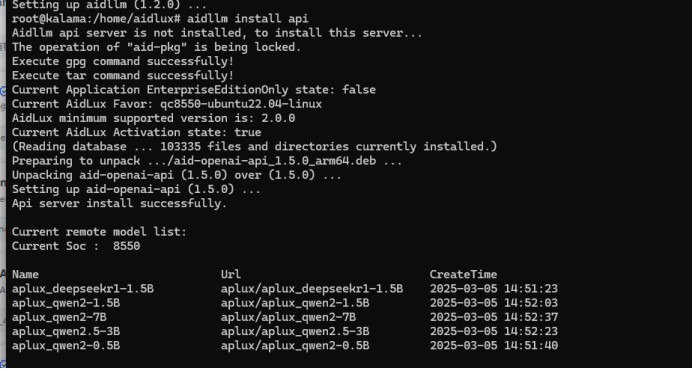

安装aidllm--大模型推理引擎

aid-pkg -i -d aidllm_1.2.0_arm64.aid.gpg

aid-pkg是aidlux的包管理工具;

aid-llm是aidlux的大模型推理引擎;

安装api服务

终端执行:

sudo aidllm install api

拉取模型文件

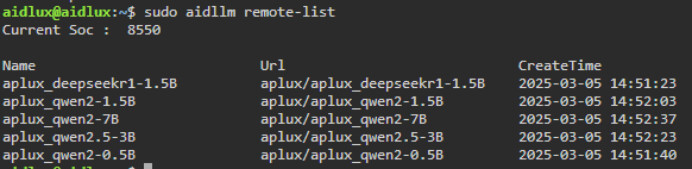

sudo aidllm remote-list

(上述列表展示当前可下载的全部模型文件,其中Current Soc 表示模型可适配的高通芯片型号)

终端执行:sudo aidllm pull <Url> ,把指定模型文件拉取到本地

如:sudo aidllm pull aplux/aplux_qwen2-7B

查看本地已下载的模型:

sudo aidllm list

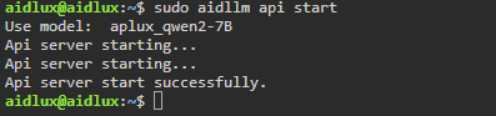

3. 启动api服务

终端执行:

sudo aidllm api start

当提示successfully,则表示API启动成功

当本地存在多个模型文件,则可以指定模型启动

终端执行:sudo aidllm api start -m <Name>

如:sudo aidllm api start -m aplux_qwen2.5-3B

查询状态: sudo aidllm api status

停止服务: sudo aidllm api stop

重启服务: sudo aidllm api restart

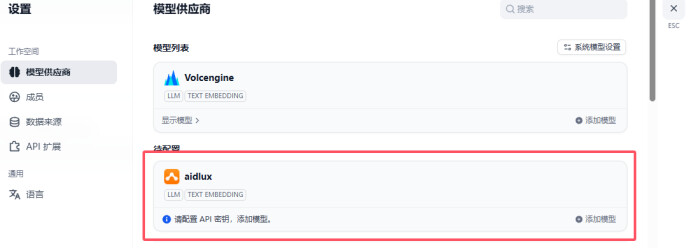

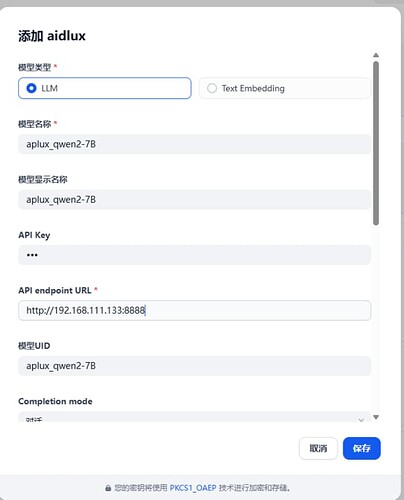

4. 导入模型

1.确认此时模型以正常启动,可在本机或其他设备上测试

curl -X POST ‘http://192.168.111.133:8888/v1/chat/completions’

–header ‘Content-Type: application/json’

–data-raw ‘{“model”: “aplux_qwen2-7b”,“api_key”: “”,“messages”: [{“role”: “system”,“content”: “You are a helpful assistant”},{“role”: “user”,“content”: “给我讲一个笑话”}],“stream”: true}’

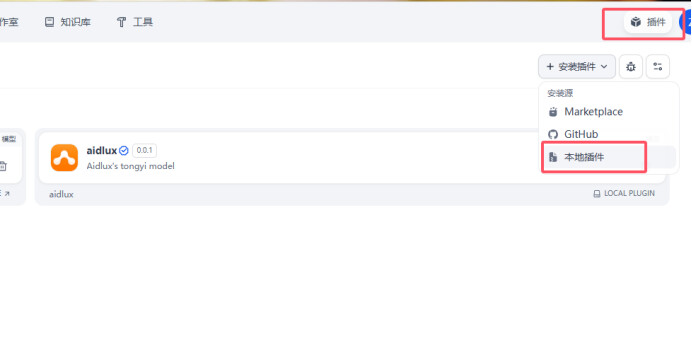

2.安装插件

3.添加模型,api-key可随意填写

5.模型添加完成后,即可添加应用、知识库结合使用

(示例)

总结

本文聚焦高通 QCS8550 平台上 Qwen2.5-7B 大语言模型与 Agent+RAG 技术的融合部署实践,核心内容可归纳为以下三方面:

1、技术背景与融合价值

硬件载体:高通 QCS8550 作为高性能计算平台,以强大算力与低功耗优势,为 AI 模型边缘部署提供支撑。

模型能力:Qwen2.5-7B 是阿里云开源的 76 亿参数大语言模型,具备 128K 长文本处理、29 种语言支持、指令遵循与代码 / 数学任务优化等特性,适配文本生成、数据分析等多场景。

智能体升级:AI Agent 通过整合 LLM、工具调用与规划推理,将被动响应转化为主动任务执行,结合 RAG 检索增强技术,可实时调用外部知识,提升复杂任务处理能力。

2、核心技术解析

Qwen2.5-7B 模型特性

参数规模 7.61B,支持 Apache 2.0 商用,基于 18T 数据预训练,在长文本生成、结构化数据理解等方面性能显著。

与全模态模型 Qwen2.5-Omni-7B 不同,专注于自然语言处理任务。

AI Agent 架构与能力

核心组件包括规划器、工具库、执行器与记忆模块,可分解任务、调用工具(如检索、计算)并迭代优化决策。

相比传统 AI,Agent 具备主动规划、实时知识更新、多步骤任务处理能力,适用于医疗辅助、金融分析、自动化工作流等场景。

3、高通平台部署实践步骤

环境搭建:安装 Dify 框架(RAG 引擎与 Agent 工具),部署 aidllm 推理引擎并下载适配 QCS8550 的 Qwen2.5-7B 模型。

服务启动:通过终端命令启动 API 服务,确保模型正常运行。

功能验证与应用集成:通过 API 调用测试模型(如生成笑话),添加插件后结合知识库构建 AI 助手,实现检索增强与智能决策。

4、技术价值与展望

本文提供的部署方案实现了大模型与智能体技术在边缘设备的落地,为开发者提供了从环境搭建到功能验证的全流程实践经验。未来,随着 AI Agent 规划能力与 RAG 效率的优化,该方案可进一步拓展至更多垂直领域,推动 AI 从工具向智能助手的角色演进。

更多推荐

已为社区贡献24条内容

已为社区贡献24条内容

所有评论(0)