AAAI 2026 | 把时间序列画成图?VLM4TS用视觉语言模型破解时序检测难题

传统方法大多基于数值建模——无论是统计模型(如 ARIMA)、深度自编码器,还是近期兴起的时序基础模型(如 TimesFM、UniTS)其共同局限在于:它们学习的是“正常数据的分布”,而非“异常的语义”。通过精心设计的 prompt,VLM 被引导执行三项操作:保留真正偏离全局模式的异常、剔除与历史行为一致的“伪异常”、并补充可能被初筛遗漏的宏观异常(如缓慢漂移)。而在日常运行阶段则完全正常。这种

通过快速视觉筛查与选择性多模态推理,实现高精度定位、低计算开销、零样本时间序列异常检测。

©PaperWeekly 原创 · 作者 | 何泽林

单位 | 宾夕法尼亚州立大学

研究方向 | 多模态大模型

论文标题:

Harnessing Vision-Language Models for Time Series Anomaly Detection

收录会议:

AAAI 2026 (Oral Presentation)

论文链接:

https://arxiv.org/abs/2506.06836

代码链接:

https://github.com/ZLHe0/VLM4TS

研究背景

时间序列异常检测(Time Series Anomaly Detection, TSAD)是工业监控、金融风控、医疗监护等关键系统中的基础能力。

传统方法大多基于数值建模——无论是统计模型(如 ARIMA)、深度自编码器,还是近期兴起的时序基础模型(如 TimesFM、UniTS)其共同局限在于:它们学习的是“正常数据的分布”,而非“异常的语义”。

这导致一个根本性问题:当异常并非极端值,而是上下文中的不协调模式时,这些模型往往失效。

例如,在航天遥测信号中,一段看似平稳的电压波动若出现在发动机点火阶段,可能就是严重故障;而在日常运行阶段则完全正常。

人类专家能迅速识别这种“情境异常”,因为他们不仅看数值,更看整体趋势、周期结构与事件时序关系。这种能力本质上是一种视觉-语义联合推理:将时间序列当作一张图,从形态中读出意义。

近年来,视觉语言模型(Vision-Language Models, VLMs)在跨模态理解任务中展现出接近人类的感知与推理能力。自然地,研究者开始尝试将时间序列“绘制成图”,交由 VLM 判断是否存在异常。

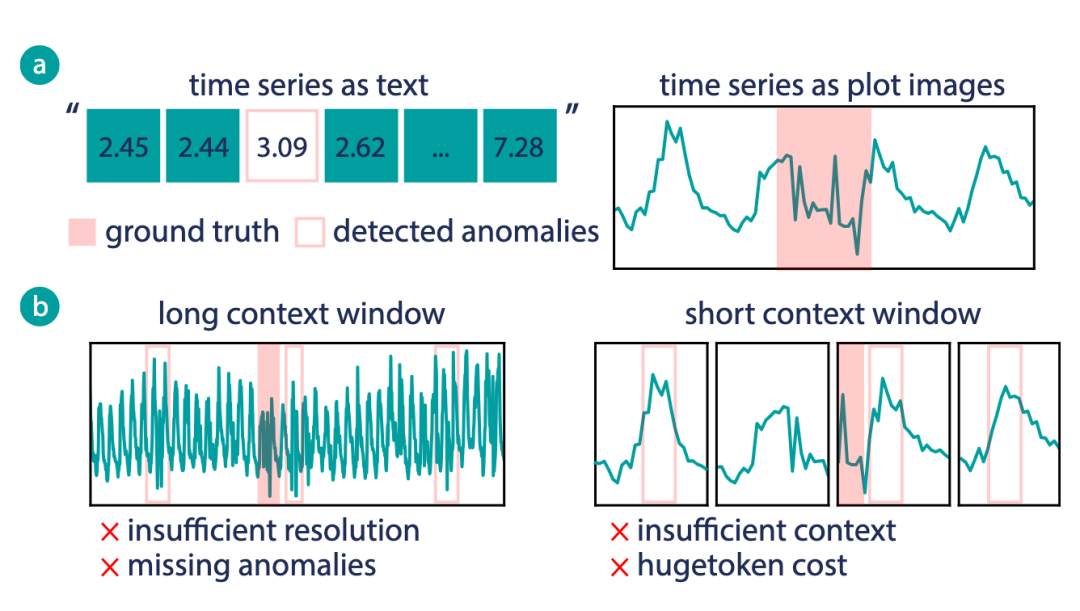

然而,这一思路在实践中遭遇两难:

-

若将整条序列渲染为一张全局图像,虽保留长期上下文,但时间轴被压缩,局部细节模糊,难以精确定位异常边界;

-

若采用滑动窗口生成高分辨率局部图像,则需对成百上千张图逐一调用 VLM,带来爆炸性的 token 消耗与推理延迟。

这种精度与效率不可兼得的困境,使得现有 VLM-based TSAD 方法要么牺牲定位准确性,要么无法部署于真实场景。

〓 (a) 时间序列的视觉表达比文本表达更适合检测任务. (b) 基于VLM异常检测的精度-上下文困境

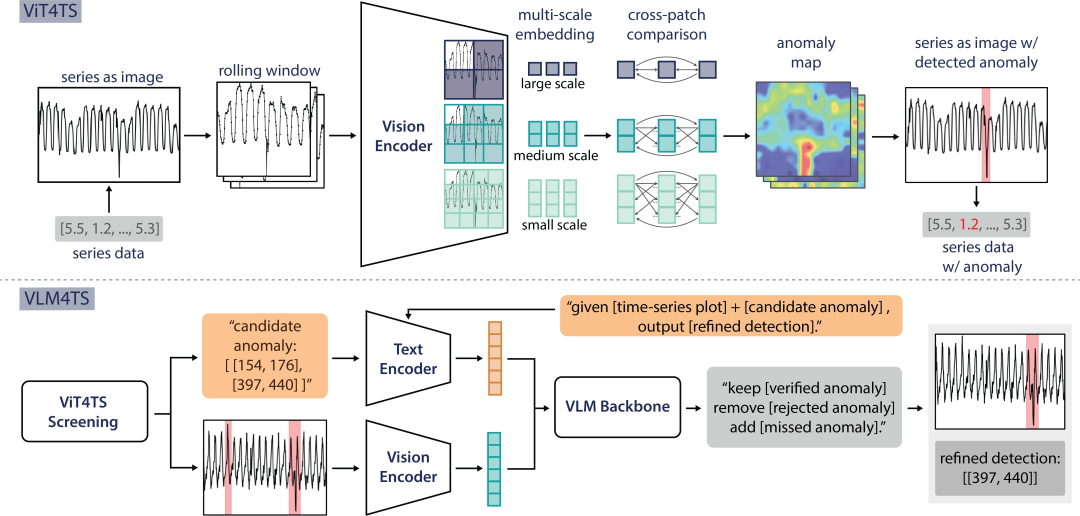

为突破这一瓶颈,本文提出 VLM4TS,一个无需任何时序数据训练的零样本检测框架。其核心洞见是:异常检测可被解耦为“定位”与“验证”两个子任务,分别由不同能力的模型高效完成。

通过 ViT4TS(基于预训练视觉编码器的轻量筛查)与 VLM4TS(基于完整视觉语言模型的语义验证)协同实现高精度定位与上下文理解。

在 11 个标准 TSAD 基准上平均 F1-max 超越最强基线 24.6%,显著优于传统时序模型与基于大语言模型的方法。

〓 VLM4TS 整体架构:ViT4TS 高效视觉初筛 + VLM4TS 全局语义验证

方法细节

阶段一(ViT4TS):利用 VLM 的视觉编码器进行高效初筛

VLM4TS 并不直接调用完整的 VLM,而是首先提取其预训练视觉编码器(如 CLIP-ViT),构建一个轻量级筛查模块 ViT4TS。该模块将原始时间序列切分为重叠滑动窗口,并将每个窗口渲染为无坐标轴的折线图。

随后,利用预训练的 ViT 编码器提取多尺度 patch 特征,通过跨窗口对比机制(以中位数特征作为“正常参考”)生成高分辨率异常热力图,并输出候选异常区间。

值得注意的是,ViT4TS 完全不涉及语言模型或微调,仅复用 VLM 中已有的视觉感知能力。这使其计算开销低,可在 CPU 上运行,且具备良好的泛化性。

〓 筛查阶段:视觉编码器激活,VLM 主干休眠,高效扫描全序列定位候选异常

阶段二(VLM4TS):调用完整 VLM 进行语义级验证

初筛虽能实现高召回,但易引入假阳性(如周期性波动被误判为异常)。

为此,VLM4TS 引入完整的 VLM Backbone(包含视觉编码器与语言模型,如 GPT-4o 或 Qwen-VL),对候选区间进行深度验证。

具体而言,系统同时向 VLM 提供两类输入:

1. 全局图像:整条时间序列的带坐标轴折线图,用于提供长期上下文;

2. 候选列表:ViT4TS 输出的可疑区间,以文本形式呈现。

〓 保留决策:VLM 主干激活,基于全局上下文确认该区间为真实异常并予以保留

通过精心设计的 prompt,VLM 被引导执行三项操作:保留真正偏离全局模式的异常、剔除与历史行为一致的“伪异常”、并补充可能被初筛遗漏的宏观异常(如缓慢漂移)。最终输出经过语义推理修正的检测结果。

〓 移除决策:VLM 主干激活,判断该区间为正常波动模式,故予以移除

这种“轻量筛查 + 重型验证”的架构,既避免了对全序列高分辨率图像的冗余处理,又确保了异常判断具备上下文合理性。

实验结果

作者在 11 个广泛使用的 TSAD 基准(涵盖传感器、网络流量、金融、航天遥测等)上系统评估了 VLM4TS。

1. 性能显著超越现有方法

VLM4TS 在 9/11 个数据集上取得最优 F1-max,平均性能比最强基线(LSTM-DT)提升 24.6%。尤其在依赖长程上下文的数据集(如 NAB 系列)中,优势更为突出。

与传统时序模型(ARIMA、LSTM-AE、TadGAN、ATrans、VAE)及预训练时序基础模型(UniTS、TimesFM)相比,VLM4TS 全面领先,表明视觉表征+多模态推理的有效性。

〓 与传统时序模型基线效果对比

与基于大语言模型的方法(如 SigLLM)相比,VLM4TS 平均领先 13.3%,且在 token 效率上优势巨大。

值得一提的是,仅使用 ViT4TS(即跳过 VLM 验证)已在多个数据集上达到 SOTA 水平,证明纯视觉筛查本身已具备强大无监督检测能力。

2. 推理效率满足实际部署需求

VLM4TS 的 token 消耗平均仅为现有 VLM/LLM 方法的 1/36。原因在于:VLM 仅对 ViT4TS 提出的少量候选区间进行推理,而非处理所有滑动窗口。

在 NVIDIA V100 上,单条数千点的时间序列可在数秒内完成全流程检测,其中 ViT4TS 可在 CPU 上运行,整体延迟与轻量级时序模型相当。这对大规模工业监控系统(如数千传感器并发)具有重要现实意义。

〓 与LLM/VLM基线效果对比

3. 消融实验验证设计必要性

〓 消融实验:核心组件的有效性验证

系统性消融表明:

-

移除多尺度特征融合导致对瞬时尖峰与长期漂移的检测能力下降;

-

移除跨窗口 patch 对比使模型无法建立“正常”参考,召回率显著降低;

-

若跳过 ViT4TS 直接调用 VLM 处理全局图像(即 VLM-Long),在 Yahoo 等高密度异常数据集上 F1-max 大幅下滑,说明缺乏高召回初筛会导致 VLM 难以在复杂背景中分离多个异常。

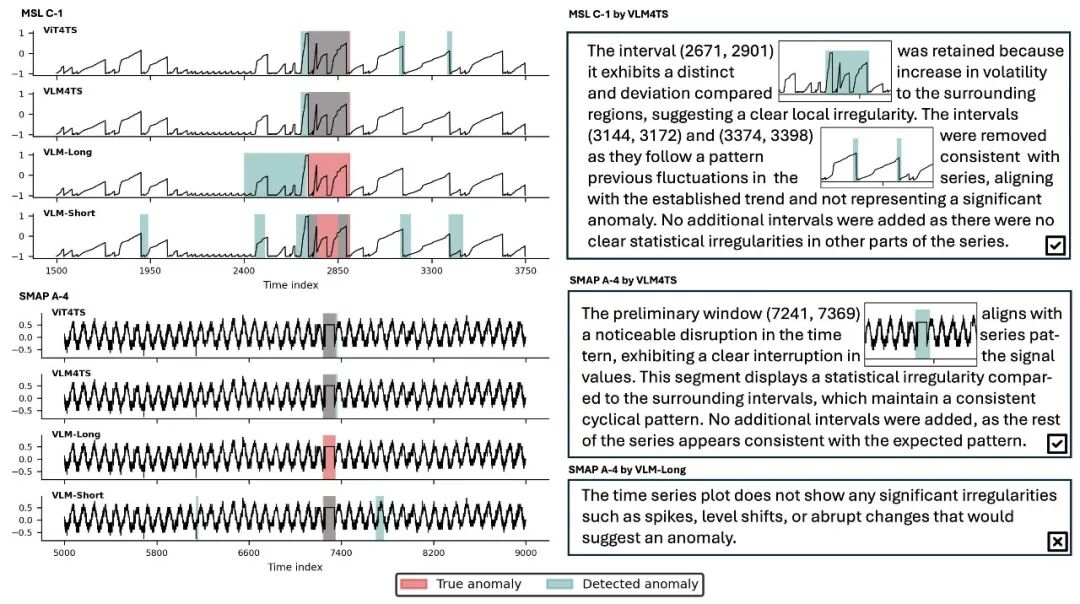

4. 案例分析:真实场景中的推理过程

〓 真实场景推理示例:VLM4TS 基于全局上下文剔除假阳性并锁定真实异常

在遥测信号中,真实异常表现为局部形态畸变而非极端值:

-

ViT4TS 成功捕获多个潜在区域(高召回),但包含误报;

-

VLM-Short(对每个窗口单独提问)因视野受限,将正常波动误判为异常;

-

VLM-Long(处理整图)虽理解全局趋势,但定位模糊,且容易遗漏真实异常;

-

VLM4TS 则精准保留真实异常、剔除假阳性,实现高置信度检测。

结语

文章揭示了一种新范式:时间序列分析不必局限于数值建模,而可借助多模态大模型的通用感知能力,模拟人类专家“先粗筛、再细判”的综合判断逻辑。

项目已开源,支持任意含 timestamp 与 value 列的 CSV 输入,提供 ViT4TS 与 VLM4TS 的完整推理流程。

对于希望探索多模态方法在时序分析中潜力的研究者与工程师,该工作提供了一个实用且可扩展的起点。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

更多推荐

已为社区贡献97条内容

已为社区贡献97条内容

所有评论(0)